W obecnym kontekście charakteryzującym się szybkim i powszechnym wdrażaniem sztucznej inteligencji w francuskich przedsiębiorstwach, korzyści są niezaprzeczalne: poprawa wydajności, przyspieszona transformacja cyfrowa oraz automatyzacja wielu zadań. Jednakże ten rozwój wiąże się z istotnymi ryzykami, często nieznanymi lub bagatelizowanymi, które mogą osłabić bezpieczeństwo, poufność, a nawet trwałość organizacji. Dyrekcja Generalna Bezpieczeństwa Wewnętrznego (DGSI) niedawno opublikowała Flash dotyczącą ingerencji, ujawniając te słabości poprzez trzy rzeczywiste przypadki doświadczone przez francuskie przedsiębiorstwa, ujawniające niebezpieczeństwa czyhające, gdy nie ma się pełnej kontroli nad stosowanymi narzędziami sztucznej inteligencji.

Przykłady te ukazują różne aspekty wyzwań technologicznych i organizacyjnych: z jednej strony manipulację danymi wrażliwymi za pomocą niekontrolowanych narzędzi zewnętrznych, z drugiej nadmierne zaufanie do autonomicznych systemów decyzyjnych, oraz wreszcie wzrost zaawansowanych ataków wykorzystujących technologie deepfake. Artykuł zagłębia się w te trzy konkretne ilustracje, aby pogłębić główne wyzwania, z jakimi borykają się francuskie przedsiębiorstwa podczas eksploracji i stosowania sztucznej inteligencji, omawiając ryzyka etyczne, uprzedzenia algorytmiczne, problemy ochrony danych oraz imperatywy bezpieczeństwa informatycznego. Również ocenione zostanie, jak odpowiednie regulacje AI, połączone z rygorystycznym zarządzaniem, mogą zapobiegać kosztownym błędom i chronić integralność struktur gospodarczych kraju.

- 1 Niewłaściwe wykorzystanie generatywnej AI: alarmujący przykład dla francuskich przedsiębiorstw

- 2 Ryzyka uzależnienia od AI w podejmowaniu decyzji strategicznych w francuskich przedsiębiorstwach

- 3 Wyrafinowane oszustwa z użyciem deepfake – narastające zagrożenie dla francuskich przedsiębiorstw

- 4 Kluczowe zalecenia dotyczące regulacji stosowania sztucznej inteligencji w francuskich przedsiębiorstwach

- 5 Statystyki i ekonomiczne skutki sztucznej inteligencji w francuskich przedsiębiorstwach

- 6 Ryzyka etyczne i uprzedzenia algorytmiczne: wyzwania dla francuskich przedsiębiorstw wobec sztucznej inteligencji

- 7 Transformacja cyfrowa i wyzwania ochrony danych w francuskich przedsiębiorstwach

- 8 Strategiczne podejście do udanej integracji AI w francuskich przedsiębiorstwach

Niewłaściwe wykorzystanie generatywnej AI: alarmujący przykład dla francuskich przedsiębiorstw

Pierwszy przypadek przedstawiony przez DGSI dotyczy strategicznej firmy, która korzystała z publicznego narzędzia generatywnej sztucznej inteligencji opracowanego za granicą do tłumaczenia wewnętrznych, wrażliwych dokumentów. Korzystanie z tego narzędzia zostało spontanicznie wprowadzone przez niektórych pracowników, zachwyconych efektywnością i szybkością, jaką oferowało w codziennym zarządzaniu treściami. Ta praktyka, rozpoczęta bez akceptacji przełożonych i wcześniejszej kontroli, szybko ujawniła swoje ograniczenia, gdy dział IT wykrył potencjalny wyciek podczas audytu wewnętrznego.

Korzystanie z darmowych lub międzynarodowych usług stanowi szczególne zagrożenie, ponieważ wprowadzane dane mogą być wykorzystywane do trenowania modeli sztucznej inteligencji w tle, często bez wyraźnej informacji dla użytkownika. Zjawisko to stanowi poważne zagrożenie dla poufności informacji, zwłaszcza gdy serwery tych firm znajdują się poza terytorium francuskim lub nawet europejskim, wystawiając dane na wpływ zagranicznych przepisów, które bywają mniej rygorystyczne.

Wobec tego stanu rzeczy firma zaprzestała korzystania z tej usługi na rzecz wewnętrznego, płatnego rozwiązania oferującego bezpieczne środowisko zgodne z krajowymi normami. Ponadto powołano specjalną grupę roboczą, która opracowuje surową doktrynę użytkowania narzędzi AI. Inicjatywa ta ilustruje kluczową potrzebę uporządkowania stosowania zaawansowanych technologii przez przedsiębiorstwa, aby unikać luk w zabezpieczeniach. Rzeczywiście, zagrożenia związane z połączeniem z zewnętrznymi interfejsami czy niekontrolowanymi wtyczkami zwiększają wektor ataku i podatność na infiltracje.

Analizując ten pierwszy przykład, staje się jasne, że pokusa sięgnięcia po proste i darmowe narzędzia może ukrywać poważne ryzyka. Dla wszystkich francuskich przedsiębiorstw angażujących się w transformację cyfrową, niezbędne jest przyjęcie proaktywnej polityki bezpieczeństwa informatycznego oraz uwzględnienie ochrony danych jako kryterium oceny narzędzi AI już na wczesnych etapach.

Ryzyka uzależnienia od AI w podejmowaniu decyzji strategicznych w francuskich przedsiębiorstwach

Drugi przypadek podkreślony przez służby wywiadowcze dotyczy scenariusza, w którym francuska firma w trakcie ekspansji międzynarodowej wydelegowała krytyczną część procesu decyzyjnego, due diligence, do systemu sztucznej inteligencji opracowanego za granicą. Celem tego działania była szybka i skuteczna ocena potencjalnych partnerów biznesowych na nieznanych rynkach.

Na krótką metę ten automatyzm okazał się atrakcyjny, generując szczegółowe i natychmiastowe raporty. Jednak z powodu dużej ilości pracy i braku specjalistycznych zasobów ludzkich do weryfikacji wyników, zespoły mają tendencję do bezkrytycznego akceptowania dostarczonych rezultatów bez dodatkowej eksperckiej walidacji. Tymczasem te algorytmiczne systemy dostarczają odpowiedzi probabilistyczne, które odpowiadają najbardziej statystycznie prawdopodobnej odpowiedzi, a nie odpowiedzi wolnej od uprzedzeń czy idealnie dopasowanej do kontekstu.

Uprzedzenia algorytmiczne, wprowadzone już na etapie projektowania modelu lub poprzez dane treningowe, mogą błędnie kierować wynikami. Ponadto słynne „halucynacje” – generujące błędne, niedokładne lub wymyślone informacje – zagrażają wiarygodności tych narzędzi. Zjawisko to zwiększa ryzyko podejmowania strategicznych decyzji na podstawie obciążonych analiz, co może skutkować stratami handlowymi, konfliktami kontraktowymi lub utratą zaufania.

Przykład ten pokazuje więc krytyczną potrzebę integracji eksperckiego nadzoru ludzkiego w pętlach decyzyjnych, na przykład poprzez wyznaczenie referentów AI odpowiedzialnych za przeformułowanie, weryfikację i wyważanie rekomendacji generowanych przez maszyny. Czujność ludzka pozostaje niezbędnym zabezpieczeniem przed redukcją różnorodności myślenia i automatycznymi decyzjami oderwanymi od realnego kontekstu francuskich przedsiębiorstw.

Ten przypadek ilustruje także inne poważne wyzwanie technologiczne: jak pogodzić optymalizację wynikającą z automatyzacji i transformacji cyfrowej z utrzymaniem rygorystycznej kontroli strategicznej? Programy szkoleniowe i podnoszenie świadomości na temat ryzyk związanych z używaniem sztucznej inteligencji stają się kluczowe dla zachowania zwinności i odporności przedsiębiorstw na konkurencyjnym rynku międzynarodowym.

Wyrafinowane oszustwa z użyciem deepfake – narastające zagrożenie dla francuskich przedsiębiorstw

Trzeci przypadek, o którym wspomina DGSI, ujawnia próbę szczególnie wyrafinowanego oszustwa związanego z wykorzystaniem technologii deepfake. Kierownik zakładu przemysłowego otrzymał wideorozmowę od rozmówcy, który perfekcyjnie imitował wygląd i głos prezesa grupy, żądając przelewu finansowego w ramach projektu przejęcia. Podstęp ten został wykryty dzięki czujności i instynktowi kierownika, który szybko przerwał rozmowę i powiadomił kierownictwo.

Technologie manipulacji audio i wideo stały się rzeczywiście niezwykle przekonujące. W okresie 2023–2025 wolumen treści deepfake w internecie wzrósł ponad dziesięciokrotnie, a codziennie krąży wiele milionów takich filmów, obrazów i nagrań. Rozwój ten został dodatkowo przyspieszony przez popularyzację narzędzi generatywnej AI oraz technik syntezy mowy.

Ataki te często opierają się na starannym zbieraniu i analizie publicznych i prywatnych danych przedsiębiorstw, by spersonalizować oszukańcze wiadomości, zwiększając ich wiarygodność i siłę manipulacji. Blisko połowa firm deklaruje, że była celem tego rodzaju prób, co ujawnia skalę problemu na francuskim rynku. Szczególnie narażony jest sektor przemysłowy, ze względu na wysokie znaczenie ekonomiczne.

Ważne jest zatem, aby francuskie przedsiębiorstwa wdrażały odpowiednie środki bezpieczeństwa informatycznego: szkolenia pracowników w rozpoznawaniu deepfake, wdrażanie ścisłych procedur weryfikacji przy prośbach o środki finansowe oraz korzystanie z technologii wykrywających sfałszowane treści. Te działania muszą towarzyszyć transformacji cyfrowej, aby zapobiec wykorzystaniu tych innowacji jako narzędzi oszustw i dezinformacji.

Kluczowe zalecenia dotyczące regulacji stosowania sztucznej inteligencji w francuskich przedsiębiorstwach

Raporty DGSI podkreślają konieczność rygorystycznej regulacji, aby zapobiegać ujawnionym zagrożeniom, jednocześnie promując adopcję sztucznej inteligencji i jej liczne korzyści. Pierwszym niezbędnym krokiem jest jasne określenie wewnętrznej polityki regulującej sposoby używania i rodzaje danych mogących być przetwarzanych przez narzędzia AI.

Francuskie przedsiębiorstwa są zachęcane do wybierania rozwiązań lokalnych lub europejskich, aby ograniczyć ryzyka związane z suwerennością danych i ochroną prawną. Ponadto kluczowe jest ciągłe szkolenie pracowników, które umożliwi im zrozumienie wyzwań, identyfikację zagrożeń oraz przyjęcie zachowań zgodnych z obowiązującymi zasadami.

DGSI rekomenduje również wdrożenie mechanizmów transparentności wewnętrznej, w szczególności kanału do zgłaszania podejrzanych incydentów, oraz regularną rewizję praktyk związanych ze sztuczną inteligencją. Włączenie specjalistycznej walidacji ludzkiej powinno być standardem, zwłaszcza w przypadku decyzji strategicznych lub wrażliwych.

Wreszcie, współpraca między sektorem publicznym i prywatnym, w tym organami regulacyjnymi AI, jest niezbędna do zdefiniowania jasnych i elastycznych ram prawnych, które z jednej strony wspierają rozwój technologiczny, a z drugiej nie zagrażają wartościom etycznym i bezpieczeństwu francuskich przedsiębiorstw.

- Określić jasną wewnętrzną politykę korzystania z AI

- Preferować rozwiązania lokalne lub europejskie

- Regularnie szkolić pracowników

- Utworzyć kanał zgłaszania incydentów

- Zapewnić systematyczną walidację ludzką dla decyzji krytycznych

- Zapewnić transparentność i regularną rewizję praktyk

- Współpracować z organami regulacyjnymi w celu dostosowania ram prawnych

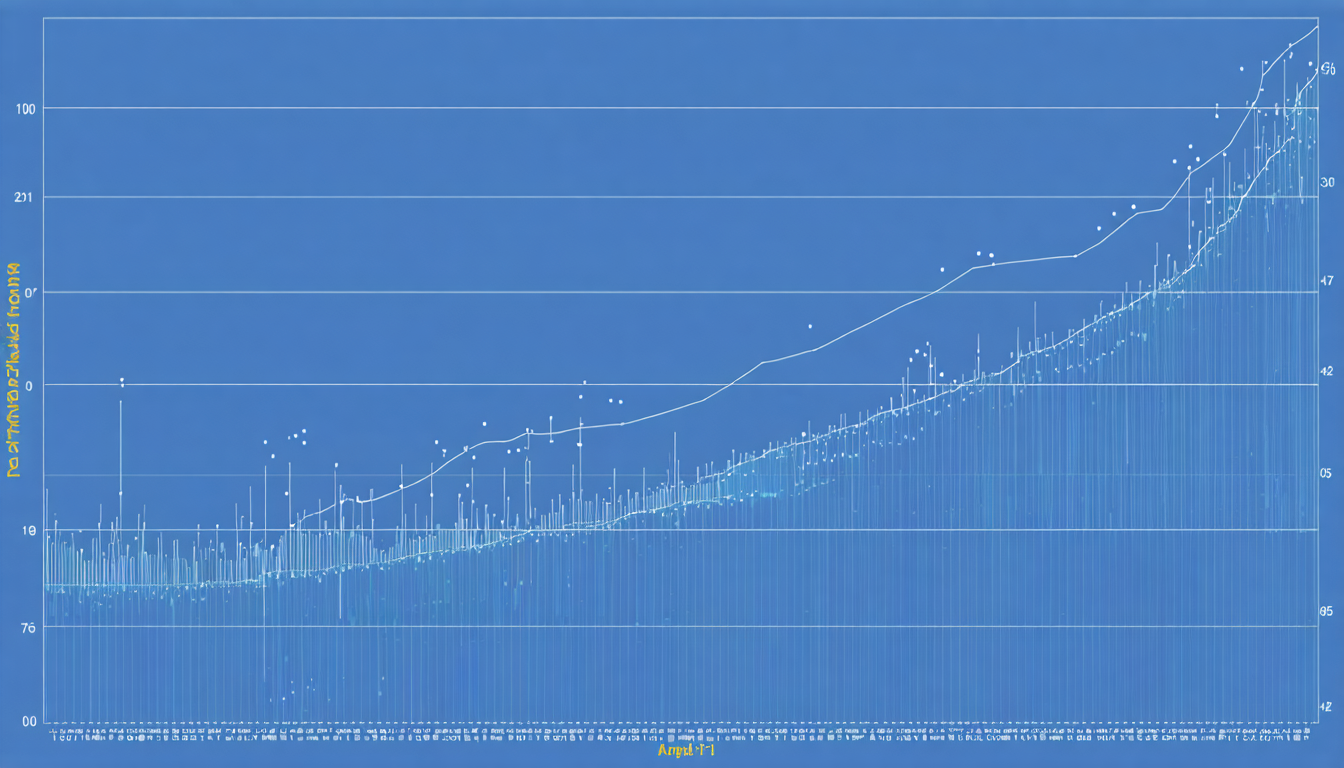

Statystyki i ekonomiczne skutki sztucznej inteligencji w francuskich przedsiębiorstwach

Dane ujawniają zróżnicowany obraz między korzyściami ekonomicznymi a potencjalnymi podatnościami. Blisko 78% światowych przedsiębiorstw już integruje sztuczną inteligencję w co najmniej jednej ze swoich funkcji. We Francji trend ten nieustannie rośnie, głównie dzięki impulsowi transformacji cyfrowej w wielu sektorach.

Według kilku badań, zyski w produktywności związane z AI mogą sięgać aż do 55%. Średnia rentowność finansowa jest szacowana na około 3,70 dolara wygenerowanego na każdy zainwestowany dolar. Perspektywy te są atrakcyjne dla kierownictwa, lecz czasem ukrywają wewnętrzne ryzyka, zwłaszcza w zakresie bezpieczeństwa informatycznego i ochrony prywatności.

Tabela ta syntetyzuje niektóre kluczowe wskaźniki:

| Wskaźnik | Wartość | Komentarze |

|---|---|---|

| Stopień adopcji AI w przedsiębiorstwach (Francja) | 70% | Silny wzrost od 2023 |

| Zyski produktywności związane z AI | Do 55% | Zmienne w zależności od sektora i zastosowania |

| Średni zwrot finansowy | 3,70 $ na zainwestowany dolar | Zdecydowana przewaga nad tradycyjnymi inwestycjami |

| Przedsiębiorstwa bez formalnej polityki AI | 1/3 | Brak zarządzania naraża na ryzyka |

| Przedsiębiorstwa celem deepfake | 46% | Szybkie rozprzestrzenianie się tego zagrożenia |

Ryzyka etyczne i uprzedzenia algorytmiczne: wyzwania dla francuskich przedsiębiorstw wobec sztucznej inteligencji

Poza kwestiami bezpieczeństwa i ochrony danych, francuskie przedsiębiorstwa mierzą się z fundamentalnym wyzwaniem związanym z uprzedzeniami algorytmicznymi. Uprzedzenia te pojawiają się wtedy, gdy dane użyte do trenowania modeli są częściowo reprezentatywne lub gdy ukryte uprzedzenia wnikają do programów. Może to prowadzić do dyskryminacji, fałszowania wyników analitycznych lub kompromitować zautomatyzowane podejmowanie decyzji.

Ryzyka etyczne związane z tymi uprzedzeniami są kluczowe, zwłaszcza dla firm działających w wrażliwych sektorach, takich jak finanse, zdrowie czy zasoby ludzkie. Na przykład AI z uprzedzeniami może niesprawiedliwie wpływać na decyzje rekrutacyjne, penalizować określone profile klientów albo faworyzować kontrowersyjne wybory handlowe.

Aby sprostać tym wyzwaniom, firmy muszą wdrażać regularne audyty algorytmów, wykonywać testy zgodności etycznej oraz wzmacniać różnorodność zespołów developerskich, by ograniczyć obszary niedostrzegalności. Ważna jest także edukacja decydentów na temat tych ryzyk oraz integracja mechanizmów korygujących.

Wreszcie, unijne regulacje AI nakładają obecnie ścisłe wymagania dotyczące oceny uprzedzeń i transparentności, co wymusza na francuskich przedsiębiorstwach dostosowanie się do tych standardów pod groźbą sankcji prawnych oraz negatywnego wpływu na ich wizerunek.

Praktyczne działania na rzecz redukcji uprzedzeń algorytmicznych

- Przeprowadzać niezależne audyty używanych modeli

- Angażować ekspertów multidyscyplinarnych w rozwój algorytmów

- Używać reprezentatywnych i zróżnicowanych zbiorów danych

- Wdrażać mechanizmy wyjaśnialności decyzji algorytmicznych

- Szkolić zespoły w zakresie ryzyk etycznych związanych z AI

Transformacja cyfrowa i wyzwania ochrony danych w francuskich przedsiębiorstwach

Transformacja cyfrowa, przyspieszona intensywnym użyciem sztucznej inteligencji, nakłada konieczność wzmocnienia polityk ochrony danych. W tym kontekście francuskie firmy muszą nie tylko przestrzegać europejskich norm RODO, ale także przewidywać specyficzne wymagania dotyczące poufności i integralności danych przetwarzanych przez systemy AI.

Manipulacja danymi wrażliwymi za pośrednictwem zautomatyzowanych interfejsów może zintensyfikować ryzyko wycieków i nadużyć. W konsekwencji polityka cyberbezpieczeństwa musi łączyć stosowanie narzędzi technicznych z rygorystycznym zarządzaniem, w tym definiowaniem jasnych ról i odpowiedzialności zaangażowanych stron.

Bezpieczeństwo danych wymaga również kontroli przepływu informacji na zewnątrz. Francuskie przedsiębiorstwa są zachęcane do ograniczania wymiany z niecertyfikowanymi platformami zewnętrznymi lub znajdującymi się poza Unią Europejską, preferując suwerenne rozwiązania zapewniające większą kontrolę nad danymi. Takie podejście pomaga utrzymać zaufanie klientów i partnerów, które jest kluczowym czynnikiem umacniania relacji handlowych na dłuższą metę.

Strategiczne podejście do udanej integracji AI w francuskich przedsiębiorstwach

Na koniec, aby zmaksymalizować szanse powodzenia transformacji cyfrowej oraz zminimalizować ryzyka, francuskie firmy muszą przyjąć globalne i zintegrowane podejście strategiczne. Zaangażowanie dotyczy nie tylko technologii sztucznej inteligencji, ale również szkolenia zespołów, rewizji procesów biznesowych oraz wdrożenia nadzoru nad bezpieczeństwem i zgodnością.

Dostosowane zarządzanie AI obejmuje wyznaczenie dedykowanych osób odpowiedzialnych, tworzenie kodeksów etycznych oraz bliską współpracę z organami regulacyjnymi. Ramy te powinny sprzyjać innowacjom, jednocześnie zapewniając odpowiedzialne i transparentne użytkowanie.

Historia tych trzech firm ilustruje, że innowacja nie idzie bez czujności. Rozwój kompetencji wewnętrznych, świadomość ryzyk oraz transparentność dozwolonych praktyk gwarantują równowagę między wykorzystaniem potencjału AI a kontrolą jej nieodłącznych zagrożeń.