W erze sztucznej inteligencji percepcja wizualna maszyn nigdy nie była tak zaawansowana. Meta, gigant technologii cyfrowych, przekroczył właśnie ważny etap ze swoimi modelami SAM3 i SAM3D, które redefiniują rozpoznawanie obrazów i widzenie komputerowe. Te nowe systemy integrują zaawansowane techniki deep learning i przetwarzania obrazów, przesuwając granice możliwego w analizie wizualnej. To nie tylko zwykła segmentacja obiektów, lecz zdolność do rozumienia, izolowania, a nawet rekonstrukcji w trzech wymiarach elementów sceny, która otwiera szerokie perspektywy.

W 2025 roku te technologie zajmują pozycję rewolucyjnych narzędzi, zdolnych przekształcić świat cyfrowy i fizyczny. Ich doskonałe osiągi w identyfikacji obiektów na podstawie prostej opisu tekstowego, zdolność utrzymywania ciągłości wizualnej w złożonych sekwencjach wideo oraz umiejętność rekonstrukcji 3D z obrazów czynią z SAM3 i SAM3D istotne innowacje. Modele te, wytrenowane na bazie ponad 11 milionów obrazów, doskonale ilustrują spektakularny potencjał połączenia sztucznej inteligencji z widzeniem komputerowym.

Ten technologiczny zwrot wpłynie nie tylko na badaczy i programistów, ale także na branże kreatywne, komercyjne i naukowe. W miarę jak przetwarzanie obrazów staje się bardziej intuicyjne, efektywne i precyzyjne, rozwój zaawansowanych modeli AI takich jak SAM3 i SAM3D obiecuje zrewolucjonizować dziedziny tak różnorodne jak nadzór, handel internetowy, robotyka czy ochrona bioróżnorodności. Odkryj szczegółowy przegląd tych innowacji i ich praktycznych implikacji w rozpoznawaniu obrazów.

- 1 Jak Meta SAM3 rewolucjonizuje rozpoznawanie obrazów dzięki inteligentnej segmentacji

- 2 SAM3D: technologia widzenia trójwymiarowego, która przekształca zwykłe zdjęcie w obiekt 3D

- 3 Szczegółowe kluczowe funkcje Meta SAM3 i SAM3D dla zaawansowanego widzenia komputerowego

- 4 Rozwój wspierany przez gigantyczny Data Engine i wpływ na precyzję

- 5 Praktyczne zastosowania Meta SAM3 / SAM3D w przemyśle, nauce i rekreacji

- 6 Obecne ograniczenia i wyzwania Meta SAM3 / SAM3D do rozważenia

- 7 Porównanie Meta SAM3 / SAM3D z innymi technologiami AI w rozpoznawaniu obrazów

- 8 Dostępność, koszty i modele użytkowania Meta SAM3 / SAM3D we współczesnym krajobrazie technologicznym

Jak Meta SAM3 rewolucjonizuje rozpoznawanie obrazów dzięki inteligentnej segmentacji

Model Meta SAM3 stanowi prawdziwy przełom w dziedzinie rozpoznawania obrazów poprzez sztuczną inteligencję. W przeciwieństwie do poprzednich generacji, ten system nie ogranicza się do analizy pojedynczych pikseli: segmentuje z wyjątkową precyzją każdy obiekt obecny na obrazie lub wideo. Ta segmentacja jest osiągana za pomocą prostego kliknięcia lub nawet podanego przez użytkownika opisu tekstowego, co radykalnie upraszcza interakcję między człowiekiem a maszyną.

Jedną z zalet SAM3 jest jego zdolność do działania bez wcześniejszego, specyficznego treningu. Innymi słowy, model może natychmiastowo wyizolować obiekt, którego nigdy wcześniej nie spotkał, bez względu na jego kształt lub cechy. Dla przykładu, amatorski fotograf chcący wyodrębnić wszystkie czerwone rowery ze sceny miejskiej musi tylko wpisać opis „wszystkie czerwone rowery”. SAM3 zidentyfikuje i wyznaczy kontury odpowiadających obiektów bez potrzeby żmudnej interwencji czy specjalnego przygotowania danych. Ta funkcja, nazywana Promptable Concept Segmentation (PCS), łączy rozumienie języka naturalnego z wizualną mocą deep learningu, co jest możliwe dzięki zaawansowanej architekturze opracowanej przez Meta.

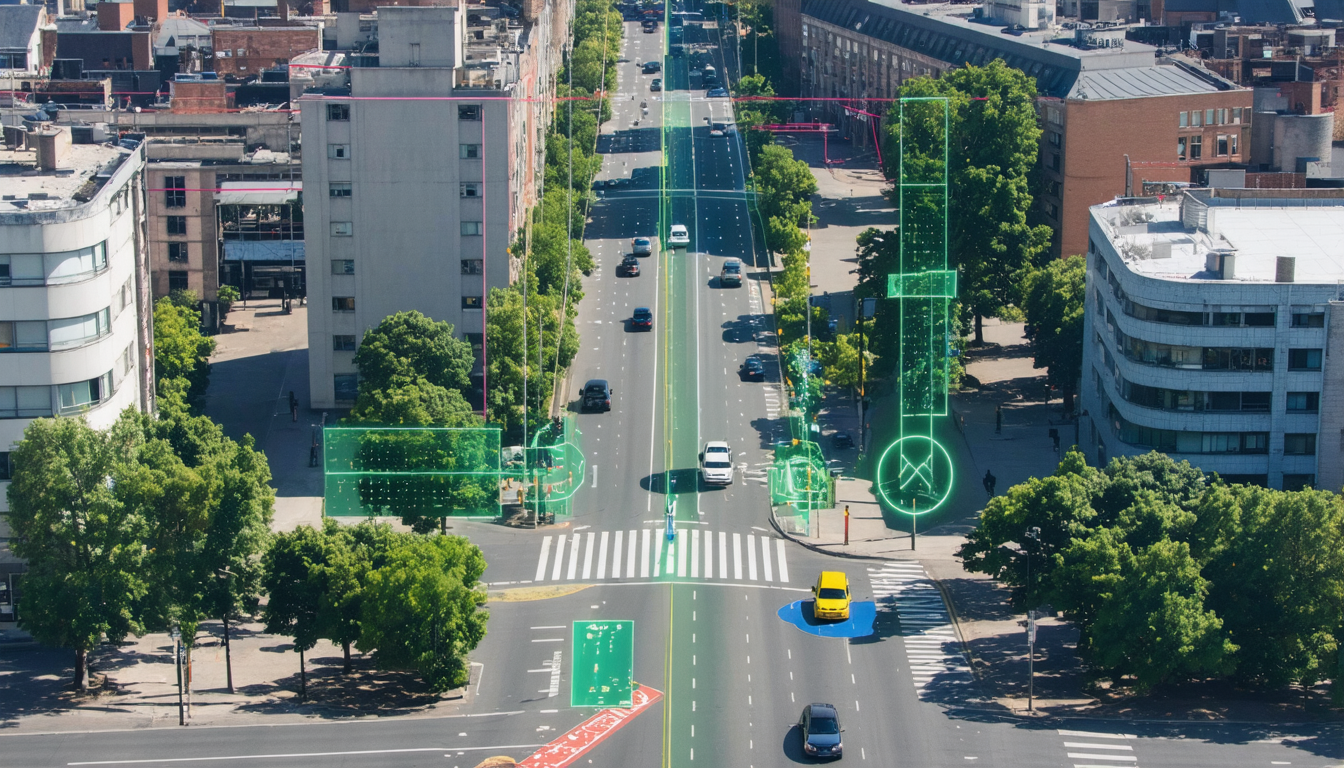

Inteligentna segmentacja nie ogranicza się do obrazów statycznych: przepływy wideo także korzystają z tego zaawansowanego przetwarzania obrazu. SAM3 używa „maskletów” do precyzyjnego śledzenia obiektów, nawet gdy są częściowo zasłonięte lub poruszają się w dynamicznych scenach. Na przykład, w nagraniu z monitoringu, jeśli osoba przemieszcza się za przeszkodą, model nadal utrzymuje jej śledzenie bez pomyłek. Ta zdolność gwarantuje wiarygodne śledzenie w czasie i otwiera drogę do zastosowań takich jak automatyczna ochrona wideo czy kreatywne narzędzia do błyskawicznego montażu filmów.

Zunifikowana architektura SAM3 wyróżnia się również unikalnym kręgosłupem, który jednakowo przetwarza obrazy oraz wideo. Ta wewnętrzna organizacja redukuje zużycie zasobów i zwiększa szybkość działania, zapewniając optymalne osiągi nawet w wymagających warunkach. Dzięki temu inżynierskiemu podejściu, SAM3 przekształca rozpoznawanie obrazu w płynne i dostępne doświadczenie, będące symbolem przełomów w sztucznej inteligencji, które w 2025 roku głęboko wpływają na widzenie komputerowe.

SAM3D: technologia widzenia trójwymiarowego, która przekształca zwykłe zdjęcie w obiekt 3D

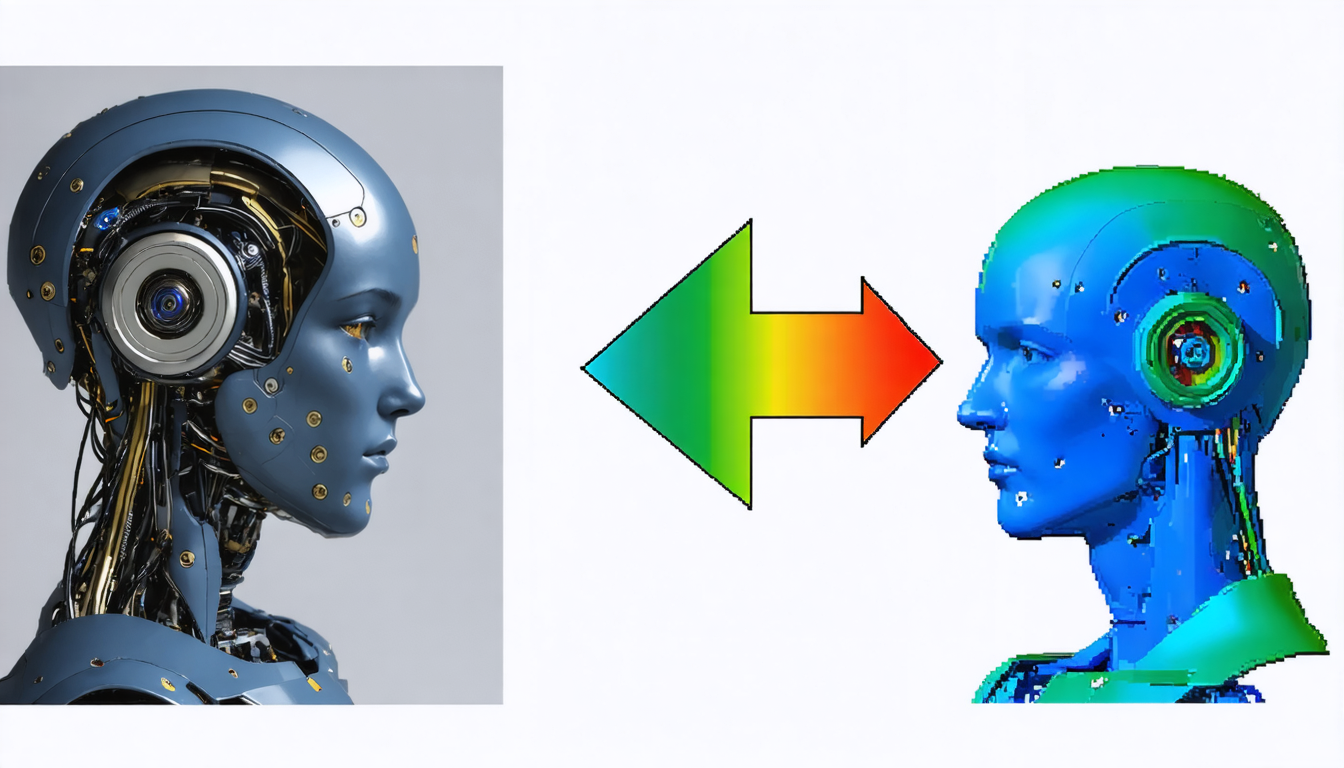

Poza klasyczną segmentacją Meta innowuje z SAM3D, modelem podnoszącym rozpoznawanie obrazów do przestrzennego, trójwymiarowego poziomu. Wykorzystując dane referencyjne z widzenia komputerowego z wieloma kamerami oraz skany LiDAR, SAM3D potrafi rekonstruować obiekty w 3D na podstawie zwykłych obrazów, otwierając nową erę w automatycznej interpretacji wizualnej.

Technologia ta opiera się na dwóch wyspecjalizowanych modułach. SAM 3D Objects jest przeznaczony do obiektów nieożywionych codziennego użytku. Na podstawie prostego zdjęcia generuje teksturowaną siatkę, którą można manipulować w trzech wymiarach, zdolną radzić sobie z częściowymi zasłonięciami. W ten sposób, jeśli obiekt jest częściowo zasłonięty przez inny, SAM3D potrafi przewidzieć brakujący kształt dzięki intensywnemu rozumowaniu logicznemu i kontekstowemu. Na przykład na obrazie, gdzie filiżanka częściowo zasłania wazon, naczynie zostanie w pełni odtworzone, co jest osiągnięciem znacznie przewyższającym możliwości tradycyjnych modeli.

Dla istot żywych, w szczególności ludzi, SAM 3D Body wdraża nowatorski model reprezentacji ciała. Rozróżnia szkielet, tkankę miękką, a nawet ubrania, umożliwiając szczegółową analizę postaw i złożonych ruchów. Ta innowacja zapewnia awatarom cyfrowym płynność i naturalność jak nigdy dotąd oraz otwiera drzwi do zastosowań w rzeczywistości wirtualnej, animacji czy ergonomii.

SAM3D stanowi więc istotny postęp w przetwarzaniu obrazów, gdyż przemienia nie tylko percepcję, ale także modelowanie obiektów. Ta immersja w trzeci wymiar wywołuje debatę nad możliwością nadania obrazom prawdziwego, fizycznego „sensu”, stanowiąc podstawę bardziej naturalnych interakcji między ludźmi a maszynami.

Szczegółowe kluczowe funkcje Meta SAM3 i SAM3D dla zaawansowanego widzenia komputerowego

Meta SAM3 i SAM3D nie ograniczają się jedynie do segmentacji i rekonstrukcji obiektów: modele te wprowadzają zestaw innowacyjnych funkcji, które radykalnie zmieniają standardowe podejście do deep learningu stosowanego w rozpoznawaniu obrazów.

Flagową funkcją jest Promptable Concept Segmentation (PCS), umożliwiająca bardzo precyzyjną segmentację pojęć wyrażonych językiem naturalnym. Ta zdolność łączy lingwistyczne rozumienie i wizualną interpretację w czasie rzeczywistym. To połączenie oferuje podwójną korzyść: z jednej strony eliminuje potrzebę kosztownej, manualnej anotacji, z drugiej zaś zwiększa dostępność narzędzi AI dla szerokiego grona użytkowników, zarówno ekspertów, jak i laików.

Wśród innych godnych uwagi funkcji można wymienić:

- Inteligentne śledzenie czasowe w wideo, wykorzystujące masklety do zachowania tożsamości obiektów nawet przy ich zasłonięciu

- Zarządzanie częściowymi zasłonięciami w 3D, umożliwiające spójną rekonstrukcję ukrytych obiektów

- Zero-Shot generalizacja, pozwalająca na rozpoznawanie obiektów nigdy wcześniej nie widzianych podczas treningu

- Mechanizm walidacji przez presence token, zapobiegający błędom interpretacji i ograniczający wizualne halucynacje

- Zunifikowana architektura zoptymalizowana pod kątem szybkiej realizacji na obrazach statycznych i strumieniach wideo

Te zaawansowane technologie bezpośrednio zwiększają możliwości praktyczne w wielu dziedzinach, ułatwiając tworzenie, automatyzację i precyzyjną analizę złożonych elementów wizualnych.

Rozwój wspierany przez gigantyczny Data Engine i wpływ na precyzję

Moc Meta SAM3 / SAM3D wynika również z ogromnej bazy danych, na której modele były trenowane. Ponad 11 milionów obrazów z anotacjami posłużyło do wyposażenia AI w szczegółowe i zróżnicowane rozumienie świata wizualnego.

Ta ogromna baza jest uzupełniona przez benchmark SA-Co, naukową kolekcję zawierającą blisko cztery miliony odrębnych, anotowanych pojęć. To bogactwo pozwala AI uchwycić najsubtelniejsze niuanse między podobnymi obiektami, jak odróżnienie „przedniego koła” od „tylnego koła” pojazdu. Przykład ten świadczy o złożoności modelu oraz jego zdolności do wyostrzania analizy wizualnej w kontekście.

Proces anotacji opiera się na innowacyjnej, hybrydowej pętli pracy: AI wykonuje automatyczną wstępną anotację, przyspieszając pracę ludzi, po czym eksperci walidują i korygują wyniki w czasie rzeczywistym. Ten szybki proces, około pięć razy bardziej wydajny niż tradycyjna ręczna anotacja, umożliwił stworzenie kolosalnego i bardzo jakościowego Data Engine.

To metodyczne podejście gwarantuje Meta SAM3 / SAM3D znaczną odporność i niezawodność, minimalizując błędy oraz „halucynacje”, z którymi borykały się wcześniejsze systemy. Wynikiem jest jednocześnie potężny i precyzyjny system, obiecujący trwałą przemianę przetwarzania obrazów na dużą skalę.

Praktyczne zastosowania Meta SAM3 / SAM3D w przemyśle, nauce i rekreacji

Zaawansowane możliwości modeli SAM3 i SAM3D szybko przyciągają różnorodne sektory, generując liczne innowacyjne zastosowania.

W handlu internetowym Facebook Marketplace już korzysta z SAM3 za pomocą funkcji „View in Room”. Funkcja ta pozwala sprzedawcom natychmiast konwertować zdjęcie produktu, takiego jak krzesło, na wirtualny obiekt 3D, pozwalając kupującemu na wizualizację bezpośrednio w jego wnętrzu dzięki rozszerzonej rzeczywistości. To immersyjne doświadczenie przełamuje zasady sprzedaży na odległość i znacząco poprawia współczynnik konwersji.

Twórcy treści na Instagramie korzystają z inteligentnych narzędzi montażowych opracowanych na bazie SAM3. Automatyzują one skomplikowane polecenia, takie jak „rozmycie tła” czy „przekształcenie nieba na czarno-białe”, wykonywane w ułamku sekundy. W ten sposób tworzenie wizualne staje się bardziej intuicyjne i dostępne, bez potrzeby zaawansowanych umiejętności technicznych.

W naukach przyrodniczych Conservation X Labs używa SAM3 do analizy ogromnych zbiorów zdjęć i wideo rejestrowanych przez fotopułapki. Automatyczne rozpoznawanie rzadkich lub zagrożonych gatunków znacznie ułatwia ekologiczny monitoring i ochronę bioróżnorodności.

Wreszcie robotyka czerpie korzyści z ulepszonej percepcji dzięki SAM3D, kluczowej dla precyzyjnej manipulacji obiektami w złożonych środowiskach. Roboty potrafią obliczyć optymalny punkt chwytu, poruszać się z łatwością w zatłoczonych przestrzeniach oraz reagować na polecenia głosowe dotyczące interakcji z nieznanymi obiektami, co redefiniuje nowoczesną robotykę.

Obecne ograniczenia i wyzwania Meta SAM3 / SAM3D do rozważenia

Mimo gwałtownego postępu w rozpoznawaniu obrazów przez sztuczną inteligencję, duet SAM3 / SAM3D nie jest wolny od wyzwań i ograniczeń technicznych.

Na przykład jakość generowanych tekstur 3D bywa czasem umiarkowana. Drobne szczegóły, takie jak włosy, delikatne sploty czy niektóre przezroczyste obiekty mogą być rozmyte lub uproszczone po wyjściu z modelu. Ta niedoskonałość ogranicza zastosowanie tych obiektów w produkcjach potrzebujących bardzo wysokiej rozdzielczości, jak filmy lub gry AAA.

Kolejne poważne wyzwanie dotyczy prawdziwego rozumienia fizycznego środowisk. Model „widzi” kształty, ale nie rozumie właściwości materiałowych takich jak grawitacja, trwałość czy kolizja. W efekcie zdarza się, że obiekty zrekonstruowane w 3D przenikają się lub nie przestrzegają praw fizyki, co wymaga ręcznej korekty w postprodukcji.

Wreszcie halucynacje wizualne, choć zmniejszone dzięki presence token, utrzymują się w złożonych i gęstych scenach, gdzie obiekty są bardzo podobne. Śledzenie wideo może czasem zawodzić, wymagając kontroli człowieka, by uniknąć krytycznych błędów, zwłaszcza w nadzorze lub medycynie.

Wysokie zużycie pamięci wideo (VRAM) do działania tych modeli ogranicza ich wdrożenie na urządzeniach mobilnych. Obecnie niezbędne są potężne środowiska obliczeniowe i niezawodne połączenie internetowe, co hamuje rozwój autonomicznych zastosowań wbudowanych.

Porównanie Meta SAM3 / SAM3D z innymi technologiami AI w rozpoznawaniu obrazów

W dynamicznie rozwijającym się sektorze istnieje wiele alternatyw dla modeli Meta, oferujących czasami bardziej wyspecjalizowane lub uzupełniające rozwiązania.

| Technologia | Szczególność | Mocne strony | Ograniczenia |

|---|---|---|---|

| Meta SAM3 / SAM3D | Zaawansowana segmentacja i rekonstrukcja 3D | Wszechstronność, Zero-Shot, zunifikowana integracja wideo-obraz | Wysokie zużycie zasobów, ograniczone tekstury 3D |

| Google DeepMind Gemini 3 | Integralna multimodalność i rozumowanie logiczne | Doskonalenie w analizie złożonych dokumentów | Mniej efektywny w czystej geometrii 3D |

| OpenAI Sora 2 | Generacja i rozumienie dynamicznego wideo | Tworzenie realistycznych scen fizycznych | Mniej odpowiedni do segmentacji |

| YOLO | Szybka detekcja i liczenie obiektów | Bardzo lekki i szybki | Mniej precyzyjny, brak rekonstrukcji 3D |

| MedSAM | Specjalizacja w obrazowaniu medycznym | Certyfikacja medyczna, wysoka precyzja | Brak wszechstronności, bardzo wyspecjalizowane zastosowania |

Ta różnorodność sprzyja powstawaniu bogatej i dopasowanej oferty do wszystkich zastosowań, gdzie popularyzacja Meta SAM3 / SAM3D idzie w parze z wyspecjalizowanymi rozwiązaniami o określonych profilach.

Dostępność, koszty i modele użytkowania Meta SAM3 / SAM3D we współczesnym krajobrazie technologicznym

Meta przyjęła ambitną politykę otwartości dla swoich modeli SAM3 i SAM3D. Wagi tych modeli są darmowe i dostępne dla środowiska naukowego, zwłaszcza poprzez popularne platformy takie jak Hugging Face. Strategia ta ma na celu ustanowienie otwartego standardu technologicznego w dziedzinie rozpoznawania obrazów i przetwarzania obrazów przez AI.

Jednak realizacja w czasie rzeczywistym wymaga wydajnej infrastruktury, szczególnie aby uzyskać przetwarzanie poniżej 30 milisekund na obraz. Obecność wydajnych procesorów graficznych takich jak H200 jest kluczowa, co ogranicza dostępność do profesjonalistów i wyspecjalizowanych centrów danych.

Dla użytkowników indywidualnych dostęp często odbywa się przez chmurę i interfejsy webowe jak Segment Anything Playground, pozwalające na darmowe testowanie tych narzędzi. Niemniej jednak pełna integracja modeli w produktach komercyjnych wymaga licencji specjalnych, często kosztownych, zwanych „SAM License”, regulujących użytkowanie i chroniących własność intelektualną Meta.

Podsumowując, technologia jest szeroko spopularyzowana dla badań, jednak jej komercjalizacja wymaga znaczących inwestycji w sprzęt i umowy prawne. Ten dualizm między bezpłatnością kodu a kosztami użytkowania jest częstą rzeczywistością w sektorze nowoczesnych, przełomowych technologii.

{„@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{„@type”:”Question”,”name”:”Quu2019est-ce que le modu00e8le Meta SAM3 ?”,”acceptedAnswer”:{„@type”:”Answer”,”text”:”Meta SAM3 est un modu00e8le du2019intelligence artificielle capable de segmenter automatiquement et rapidement nu2019importe quel objet pru00e9sent dans une image ou une vidu00e9o u00e0 partir du2019une simple description textuelle ou du2019un clic.”}},{„@type”:”Question”,”name”:”Comment SAM3D transforme-t-il les images en objets 3D ?”,”acceptedAnswer”:{„@type”:”Answer”,”text”:”SAM3D utilise des donnu00e9es issues de la vision multi-camu00e9ras et des scans LiDAR pour reconstruire des objets en trois dimensions u00e0 partir du2019une seule photo, en gu00e9nu00e9rant des maillages texturu00e9s manipulables.”}},{„@type”:”Question”,”name”:”Quels sont les avantages de la segmentation conceptuelle (PCS) ?”,”acceptedAnswer”:{„@type”:”Answer”,”text”:”La segmentation conceptuelle permet u00e0 lu2019utilisateur de demander au modu00e8le du2019isoler pru00e9cisu00e9ment des objets selon des descriptions en langage naturel, sans nu00e9cessiter du2019entrau00eenement spu00e9cifique, rendant les outils accessibles et puissants.”}},{„@type”:”Question”,”name”:”Quels secteurs bu00e9nu00e9ficient le plus de Meta SAM3 / SAM3D ?”,”acceptedAnswer”:{„@type”:”Answer”,”text”:”Les secteurs comme le commerce en ligne, la cru00e9ation de contenu, la robotique, la surveillance vidu00e9o et la conservation de la biodiversitu00e9 exploitent activement ces technologies pour amu00e9liorer leurs processus.”}},{„@type”:”Question”,”name”:”Est-ce que SAM3 / SAM3D sont accessibles gratuitement ?”,”acceptedAnswer”:{„@type”:”Answer”,”text”:”Les modu00e8les sont accessibles gratuitement pour la recherche via des plateformes ouvertes, mais lu2019utilisation commerciale demande souvent des licences spu00e9cifiques et une infrastructure de calcul cou00fbteuse.”}}]}Czym jest model Meta SAM3?

Meta SAM3 to model sztucznej inteligencji zdolny do automatycznej i szybkiej segmentacji dowolnego obiektu widocznego na obrazie lub filmie na podstawie prostego opisu tekstowego lub kliknięcia.

Jak SAM3D przekształca obrazy w obiekty 3D?

SAM3D wykorzystuje dane pochodzące z wielokamerowego widzenia oraz skany LiDAR do rekonstrukcji obiektów w trzech wymiarach na podstawie pojedynczego zdjęcia, generując manipulowalne, teksturowane siatki.

Jakie są zalety segmentacji koncepcyjnej (PCS)?

Segmentacja koncepcyjna pozwala użytkownikowi na precyzyjne wyodrębnienie obiektów według opisów w języku naturalnym bez konieczności specjalistycznego treningu, czyniąc narzędzia dostępnymi i potężnymi.

Które sektory najbardziej korzystają z Meta SAM3 / SAM3D?

Sektory takie jak handel internetowy, tworzenie treści, robotyka, monitoring wideo i ochrona bioróżnorodności aktywnie wykorzystują te technologie do usprawniania swoich procesów.

Czy SAM3 / SAM3D są dostępne bezpłatnie?

Modele są dostępne bezpłatnie do celów badawczych za pośrednictwem otwartych platform, ale zastosowania komercyjne często wymagają specjalistycznych licencji i kosztownej infrastruktury obliczeniowej.