À l’ère de l’intelligence artificielle, la perception visuelle des machines n’a jamais été aussi poussée. Meta, géant des technologies numériques, vient de franchir une étape capitale avec ses modèles SAM3 et SAM3D, qui redéfinissent la reconnaissance d’image et la vision par ordinateur. Ces nouveaux systèmes intègrent des techniques avancées de deep learning et de traitement d’images, repoussant les frontières du possible dans l’analyse visuelle. Plus qu’une simple segmentation d’objets, c’est une capacité à comprendre, isoler et même reconstruire en trois dimensions les éléments d’une scène qui ouvre de vastes horizons.

En 2025, ces technologies se positionnent comme des outils révolutionnaires, capables de transformer le monde numérique et physique. Leurs performances supérieures dans l’identification d’objets à partir d’une simple description textuelle, leur aptitude à maintenir la continuité visuelle dans des séquences vidéo complexes, et leur capacité de reconstitution 3D à partir d’images font de SAM3 et SAM3D des innovations majeures. Ces modèles entraînés sur une base de plus de 11 millions d’images illustrent parfaitement le potentiel spectaculaire du croisement entre intelligence artificielle et vision par ordinateur.

Ce virage technologique impactera non seulement les chercheurs et développeurs, mais également les industries créatives, commerciales et scientifiques. Alors que le traitement d’images devient plus intuitif, efficace et précis, l’essor des modèles IA avancés comme SAM3 et SAM3D promet de réinventer des domaines aussi divers que la surveillance, le commerce en ligne, la robotique ou encore la conservation de la biodiversité. Découvrez un panorama détaillé de ces innovations et de leurs implications concrètes dans la reconnaissance d’image.

- 1 Comment Meta SAM3 révolutionne la reconnaissance d’image grâce à la segmentation intelligente

- 2 SAM3D : la technologie de vision tridimensionnelle qui transforme une simple photo en objet 3D

- 3 Fonctionnalités clés détaillées de Meta SAM3 et SAM3D pour la vision par ordinateur avancée

- 4 Le développement soutenu par un gigantesque Data Engine et l’impact sur la précision

- 5 Applications concrètes de Meta SAM3 / SAM3D dans l’industrie, la science et les loisirs

- 6 Les contraintes et limites actuelles de Meta SAM3 / SAM3D à considérer

- 7 Comparatif entre Meta SAM3 / SAM3D et autres technologies IA de reconnaissance d’image

- 8 Accessibilité, coûts et modèles d’usage de Meta SAM3 / SAM3D dans le paysage technologique actuel

Comment Meta SAM3 révolutionne la reconnaissance d’image grâce à la segmentation intelligente

Le modèle Meta SAM3 s’impose comme une véritable avancée dans le domaine de la reconnaissance d’image par intelligence artificielle. Contrairement aux générations précédentes, ce système ne se contente pas d’analyser des pixels isolés : il segmente avec une précision exceptionnelle chaque objet présent dans une image ou une vidéo. Cette segmentation est obtenue à partir d’un simple clic ou même d’une description textuelle donnée par l’utilisateur, ce qui simplifie radicalement l’interaction entre l’humain et la machine.

Une des forces de SAM3 réside dans sa capacité à fonctionner sans entraînement préalable spécifique. Autrement dit, le modèle peut isoler instantanément un objet jamais rencontré auparavant, quelle que soit sa forme ou ses caractéristiques. Pour illustrer, un photographe amateur souhaitant extraire tous les vélos rouges d’une scène urbaine n’a qu’à écrire la description « tous les vélos rouges ». SAM3 identifiera et tracera les contours des objets correspondants sans nécessiter d’intervention laborieuse ou de préparation spécifique des données. Cette fonctionnalité, appelée Promptable Concept Segmentation (PCS), mélange la compréhension du langage naturel à la puissance visuelle du deep learning, une combinaison rendue possible par l’architecture sophistiquée développée par Meta.

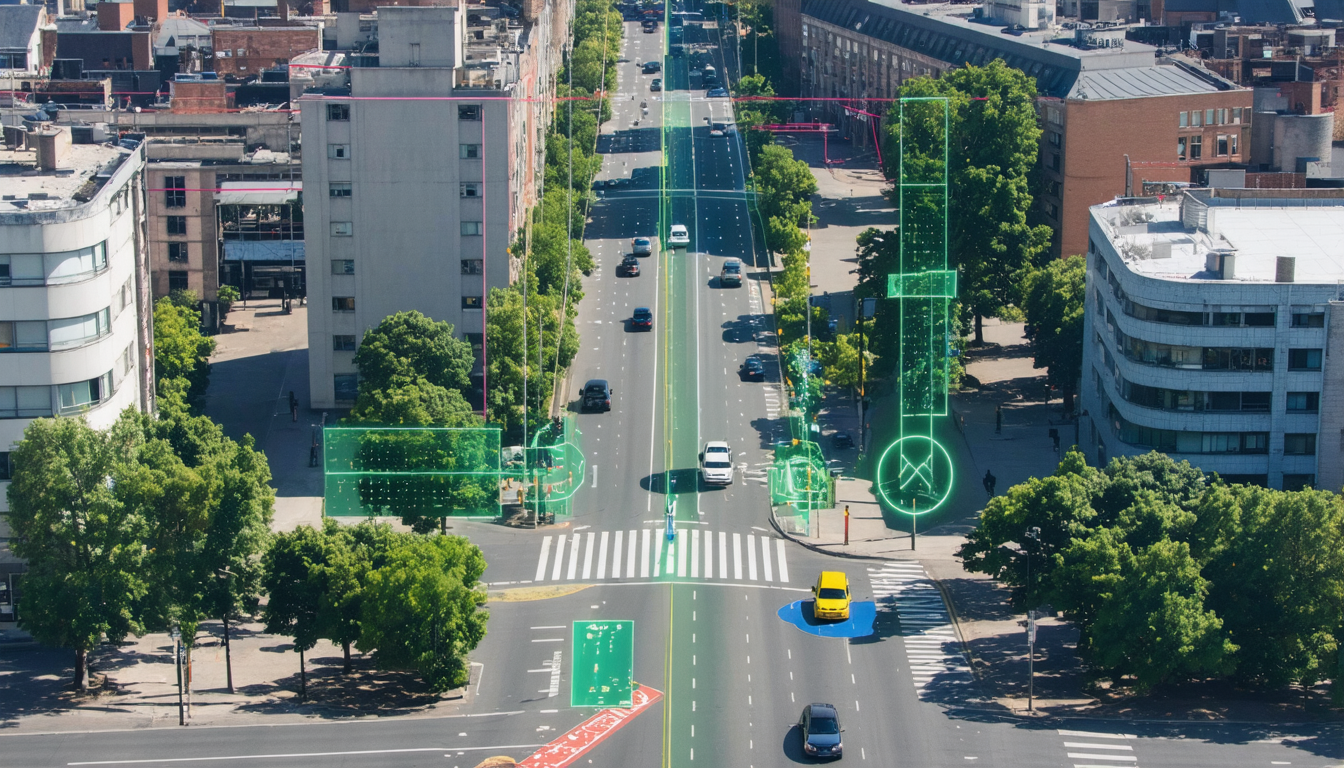

La segmentation intelligente ne s’arrête pas à l’image fixe : les flux vidéo bénéficient eux aussi de ce traitement d’images avancé. SAM3 utilise des « masklets » pour suivre précisément les objets, même lorsqu’ils sont partiellement occultés ou évoluent dans des scènes dynamiques. Par exemple, dans une vidéo de surveillance, si une personne se déplace derrière un obstacle, le modèle continue de maintenir son suivi sans confusion. Cette capacité garantit un suivi temporel fiable et ouvre la voie à des applications comme la vidéoprotection automatisée ou les outils créatifs de montage vidéo instantané.

L’architecture unifiée de SAM3 se distingue aussi par sa colonne vertébrale unique qui traite uniformément images et vidéos. Cette organisation interne réduit la consommation de ressources et augmente la rapidité d’exécution, fournissant des performances optimales même dans des contextes exigeants. Grâce à cette ingénierie, SAM3 transforme la reconnaissance d’image en une expérience fluide et accessible, emblématique des avancées en intelligence artificielle qui marquent profondément la vision par ordinateur en 2025.

SAM3D : la technologie de vision tridimensionnelle qui transforme une simple photo en objet 3D

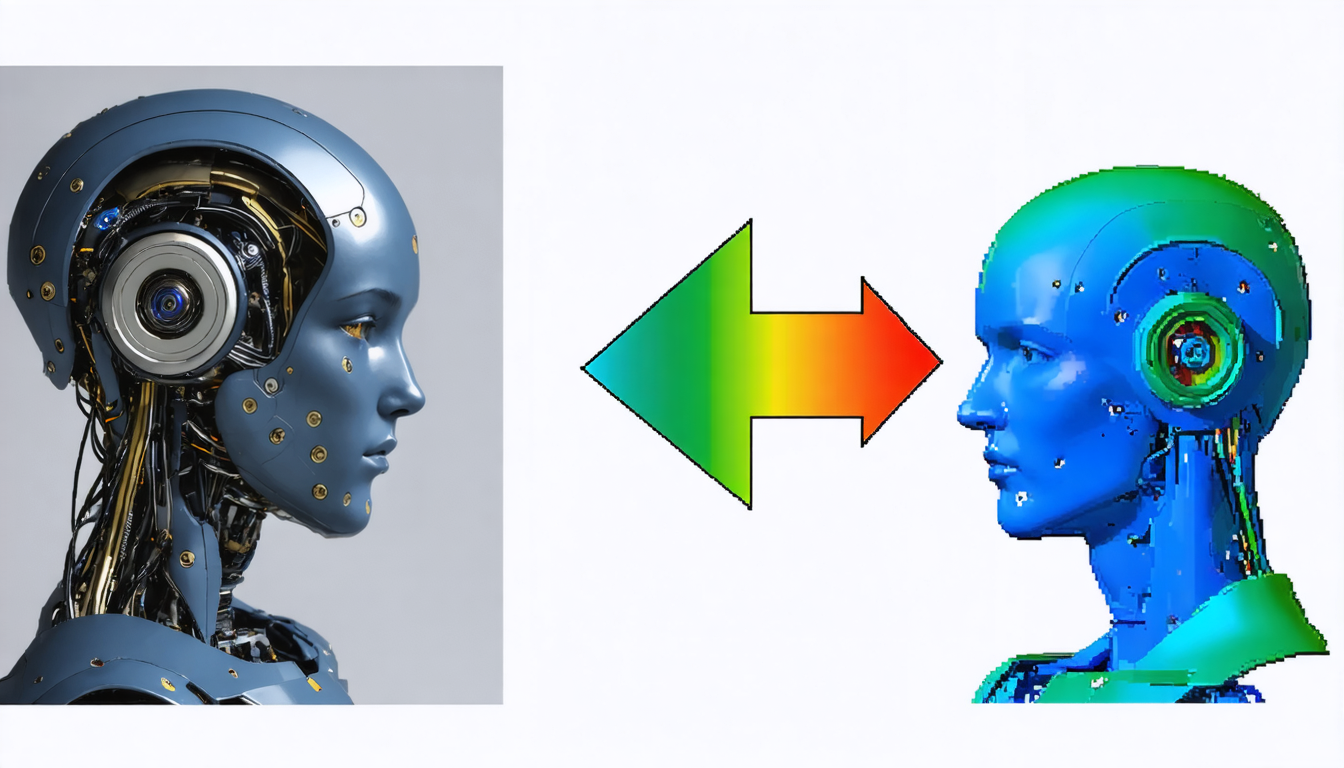

Au-delà de la segmentation classique, Meta innove avec SAM3D, un modèle qui élève la reconnaissance d’image au niveau spatial tridimensionnel. Utilisant des données de référence issues de la vision par ordinateur multi-caméras et des scans LiDAR, SAM3D parvient à reconstruire des objets en 3D à partir d’images ordinaires, ouvrant une nouvelle ère dans l’interprétation visuelle automatique.

Cette technologie s’appuie sur deux modules spécialisés. SAM 3D Objects s’adresse aux objets inanimés du quotidien. À partir d’une simple photo, il génère un maillage texturé manipulable en trois dimensions, capable de gérer les occultations partielles. Ainsi, si un objet est partiellement caché derrière un autre, SAM3D peut prédire la forme manquante grâce à un raisonnement logique et contextuel intense. Par exemple, dans une image où une tasse masque partiellement un vase, le récipient sera reconstruit dans sa totalité, un exploit qui dépasse largement les capacités des modèles traditionnels.

Pour les êtres vivants, notamment les humains, SAM 3D Body déploie un modèle inédit de représentation corporelle. Il distingue entre le squelette, la chair et même les vêtements, permettant une analyse fine des poses et des mouvements complexes. Cette innovation apporte aux avatars numériques une fluidité et un naturel jamais vus et ouvre la voie à des applications en réalité virtuelle, en animation ou en ergonomie.

SAM3D constitue ainsi une avancée majeure en matière de traitement d’images car il transforme non seulement la perception mais aussi la modélisation des objets. Cette immersion dans la troisième dimension ouvre le débat sur la possibilité d’introduire un réel « sens » physique aux images, servant de fondement à des interactions plus naturelles entre humains et machines.

Fonctionnalités clés détaillées de Meta SAM3 et SAM3D pour la vision par ordinateur avancée

Meta SAM3 et SAM3D ne se résument pas uniquement à une segmentation et reconstruction d’objets : ces modèles introduisent un ensemble de fonctionnalités novatrices qui bouleversent l’approche standard du deep learning appliqué à la reconnaissance d’image.

La feature phare, Promptable Concept Segmentation (PCS), permet de segmenter avec une grande précision des concepts exprimés en langage naturel. Cette capacité fusionne compréhension linguistique et interprétation visuelle en temps réel. Cette alliance offre un double avantage : d’une part, elle supprime la nécessité d’annotations manuelles coûteuses et, d’autre part, elle augmente l’accessibilité aux outils IA pour un large public, qu’il soit expert ou néophyte.

Parmi d’autres fonctionnalités remarquables, on peut citer :

- Le suivi temporel intelligent dans les vidéos, qui utilise les masklets pour conserver l’identité des objets même en cas d’occultation

- La gestion des occlusions partielles en 3D, permettant la reconstruction cohérente d’objets cachés

- La capacité de généralisation « Zero-Shot », offrant la reconnaissance d’objets jamais rencontrés en phase d’entraînement

- Un mécanisme de validation par presence token, évitant les erreurs d’interprétation et limitant les hallucinations visuelles

- Une architecture unifiée optimisée pour l’exécution rapide sur images fixes et flux vidéo

Ces technologies avancées ont pour effet direct de multiplier les possibilités d’usages réels dans de nombreux domaines, facilitant la création, l’automatisation et l’analyse précise d’éléments visuels complexes.

Le développement soutenu par un gigantesque Data Engine et l’impact sur la précision

La puissance de Meta SAM3 / SAM3D tient également à l’immense base de données sur laquelle les modèles ont été entraînés. Plus de 11 millions d’images annotées ont servi à doter l’IA d’une compréhension fine et diversifiée du monde visuel.

Cette base massive est complétée par le benchmark SA-Co, une collection scientifique incluant près de quatre millions de concepts distincts annotés. Cette richesse permet à l’IA de saisir les nuances subtilissimes entre des objets proches, comme différencier une « roue avant » d’une « roue arrière » sur un véhicule. Un exemple qui témoigne de la sophistication du modèle et de sa capacité à affiner l’analyse visuelle en contexte.

Le procédé d’annotation s’appuie sur une boucle de travail hybride innovante : l’IA effectue une pré-annotation automatique accélérant le travail humain, puis les experts valident et corrigent en temps réel. Ce processus rapide, environ cinq fois plus efficace que l’annotation manuelle traditionnelle, a permis de créer un Data Engine colossal et extrêmement qualitatif.

Cette approche méthodique garantit à Meta SAM3 / SAM3D une robustesse et une fiabilité importantes, minimisant les erreurs et les « hallucinations » dont souffraient les systèmes antérieurs. Le résultat est un système à la fois puissant et précis qui promet de transformer durablement le traitement d’images à grande échelle.

Applications concrètes de Meta SAM3 / SAM3D dans l’industrie, la science et les loisirs

Les capacités avancées des modèles SAM3 et SAM3D séduisent rapidement des secteurs variés, générant de nombreuses applications innovantes.

Dans le commerce en ligne, Facebook Marketplace exploite déjà SAM3 via la fonction « View in Room ». Cette fonctionnalité permet aux vendeurs de convertir instantanément la photo d’un produit, telle une chaise, en objet 3D virtuel afin que l’acheteur puisse le visualiser directement dans son intérieur via la réalité augmentée. Une expérience immersive qui bouscule les codes de la vente à distance et améliore significativement le taux de conversion.

Les créateurs de contenu sur Instagram profitent des outils de montage intelligents développés à partir de SAM3. Ceux-ci automatisent des commandes complexes, comme « flouter l’arrière-plan » ou « passer le ciel en noir et blanc », exécutées en une fraction de seconde. Ainsi, la création visuelle devient plus intuitive et accessible, sans besoin de compétences techniques poussées.

En sciences naturelles, Conservation X Labs utilise SAM3 pour analyser d’immenses volumes d’images et de vidéos capturées par des pièges photographiques. Identifier automatiquement des espèces rares ou menacées facilite grandement la surveillance écologique et la protection de la biodiversité.

Enfin, la robotique bénéficie d’une perception améliorée via SAM3D, essentielle pour la manipulation précise d’objets dans des environnements complexes. Les robots peuvent calculer le point de préhension optimal, naviguer avec aisance dans des espaces encombrés et réagir à des commandes vocales pour interagir avec des objets inconnus, une avancée qui redéfinit la robotique moderne.

Les contraintes et limites actuelles de Meta SAM3 / SAM3D à considérer

Malgré son avancée fulgurante dans la reconnaissance d’image par intelligence artificielle, le duo SAM3 / SAM3D n’est pas exempt de défis et de contraintes techniques.

Par exemple, la qualité des textures 3D générées reste parfois modérée. Les détails fins comme les cheveux, les mailles fines ou certains objets transparents peuvent apparaître flous ou simplifiés à la sortie du modèle. Cette insuffisance limite l’usage de ces objets dans des productions nécessitant une résolution cinématographique très élevée, comme les films ou jeux AAA.

Un autre défi majeur se trouve dans la compréhension physique réelle des environnements. Le modèle « voit » les formes mais ne comprend pas les propriétés matérielles comme la gravité, la solidité ou la collision. Ainsi, il arrive que des objets reconstruits en 3D se traversent ou s’interpénètrent sans respecter les lois physiques, une limite à compenser par une intervention manuelle en post-production.

Enfin, les hallucinations visuelles, bien que réduites grâce au presence token, subsistent dans les scènes complexes et chargées où des objets se ressemblent fortement. Le suivi vidéo peut parfois décrocher, obligeant un contrôle humain pour éviter les erreurs critiques, notamment dans la surveillance ou le médical.

La consommation élevée de mémoire vidéo (VRAM) pour faire tourner ces modèles limite également leur déploiement sur appareils mobiles. Actuellement, un environnement informatique puissant et une connexion internet robuste sont indispensables, freinant l’essor d’usages embarqués autonomes.

Comparatif entre Meta SAM3 / SAM3D et autres technologies IA de reconnaissance d’image

Dans un secteur en pleine effervescence, de nombreuses alternatives existent face aux modèles Meta, offrant des solutions parfois plus spécialisées ou complémentaires.

| Technologie | Spécificité | Points forts | Limites |

|---|---|---|---|

| Meta SAM3 / SAM3D | Segmentation avancée et reconstruction 3D | Polyvalence, Zero-Shot, intégration vidéo-image unifiée | Consommation élevée, textures 3D limitées |

| Google DeepMind Gemini 3 | Multimodalité intégrale et raisonnement logique | Excellence en analyse documentaire complexe | Moins performant en géométrie 3D pure |

| OpenAI Sora 2 | Génération et compréhension vidéo dynamique | Création de scènes physiques réalistes | Moins adapté à la segmentation |

| YOLO | Détection et comptage rapide d’objets | Extrêmement léger et rapide | Moins précis, pas de reconstruction 3D |

| MedSAM | Spécialisé en imagerie médicale | Certification médicale, haute précision | Non polyvalent, usage très ciblé |

Cette diversité favorise l’émergence d’une offre riche et adaptée à tous les usages, où la généralisation de Meta SAM3 / SAM3D s’accompagne de solutions spécialisées aux profils spécifiques.

Accessibilité, coûts et modèles d’usage de Meta SAM3 / SAM3D dans le paysage technologique actuel

Meta a choisi une politique d’ouverture ambitieuse pour ses modèles SAM3 et SAM3D. Les poids de ces modèles sont gratuits et accessibles à la recherche, notamment via des plateformes populaires comme Hugging Face. Cette stratégie répond à un objectif d’imposer un standard technologique ouvert dans le domaine de la reconnaissance d’image et du traitement d’images par IA.

Cependant, l’exécution en temps réel requiert une infrastructure puissante, surtout pour obtenir un traitement en moins de 30 millisecondes par image. La présence de processeurs graphiques performants comme le H200 est essentielle, limitant la disponibilité aux professionnels et centres de données spécialisés.

Pour les utilisateurs grand public, l’accès passe souvent par le cloud et des interfaces web comme le Segment Anything Playground, qui permet de tester ces outils gratuitement. Néanmoins, pour intégrer pleinement ces modèles dans des produits commerciaux, il faut composer avec des licences spécifiques et souvent coûteuses nommées « SAM License », encadrant l’usage et protégeant la propriété intellectuelle de Meta.

En résumé, la technologie est largement démocratisée pour la recherche mais son industrialisation demande des investissements significatifs en matériel et en contrats juridiques. Cette dualité entre gratuité du code et coût d’usage est une réalité fréquente dans le secteur des technologies révolutionnaires de pointe.

Qu’est-ce que le modèle Meta SAM3 ?

Meta SAM3 est un modèle d’intelligence artificielle capable de segmenter automatiquement et rapidement n’importe quel objet présent dans une image ou une vidéo à partir d’une simple description textuelle ou d’un clic.

Comment SAM3D transforme-t-il les images en objets 3D ?

SAM3D utilise des données issues de la vision multi-caméras et des scans LiDAR pour reconstruire des objets en trois dimensions à partir d’une seule photo, en générant des maillages texturés manipulables.

Quels sont les avantages de la segmentation conceptuelle (PCS) ?

La segmentation conceptuelle permet à l’utilisateur de demander au modèle d’isoler précisément des objets selon des descriptions en langage naturel, sans nécessiter d’entraînement spécifique, rendant les outils accessibles et puissants.

Quels secteurs bénéficient le plus de Meta SAM3 / SAM3D ?

Les secteurs comme le commerce en ligne, la création de contenu, la robotique, la surveillance vidéo et la conservation de la biodiversité exploitent activement ces technologies pour améliorer leurs processus.

Est-ce que SAM3 / SAM3D sont accessibles gratuitement ?

Les modèles sont accessibles gratuitement pour la recherche via des plateformes ouvertes, mais l’utilisation commerciale demande souvent des licences spécifiques et une infrastructure de calcul coûteuse.