Nel contesto attuale segnato da un’adozione rapida e generalizzata dell’intelligenza artificiale nelle imprese francesi, i benefici sono innegabili: miglioramento della produttività, accelerazione della trasformazione digitale e automazione di numerosi compiti. Tuttavia, questo sviluppo si accompagna a rischi significativi, talvolta poco conosciuti o minimizzati, che possono indebolire la sicurezza, la riservatezza e persino la sostenibilità delle organizzazioni. La Direction Générale de la Sécurité Intérieure (DGSI) ha recentemente pubblicato un Flash ingérence che mette in luce queste fragilità attraverso tre casi reali vissuti da imprese francesi, rivelatori dei pericoli che si celano quando non si domina completamente gli strumenti di intelligenza artificiale impiegati.

Questi esempi espongono diverse sfaccettature delle sfide tecnologiche e organizzative: da un lato, la manipolazione di dati sensibili tramite strumenti esterni non controllati, dall’altro, la fiducia eccessiva accordata a sistemi decisionali autonomi, e infine, la crescita di attacchi sofisticati che utilizzano tecnologie deepfake. Questo articolo si immerge in queste tre illustrazioni concrete per approfondire le principali problematiche che le imprese francesi incontrano nella loro esplorazione e uso dell’intelligenza artificiale, trattando rischi etici, bias algoritmici, problematiche di protezione dei dati e imperativi di sicurezza informatica. Si valuterà anche come una regolamentazione IA appropriata, unita a una governance rigorosa, possa prevenire errori costosi e preservare l’integrità delle strutture economiche nazionali.

- 1 Uso inappropriato dell’IA generativa: un esempio allarmante per le imprese francesi

- 2 Pericoli della dipendenza dall’IA per le decisioni strategiche nelle imprese francesi

- 3 Truffe sofisticate via deepfake, una minaccia crescente per le imprese francesi

- 4 Raccomandazioni chiave per incorniciare l’uso dell’intelligenza artificiale nelle imprese francesi

- 5 Statistiche e impatti economici dell’intelligenza artificiale nelle imprese francesi

- 6 Rischi etici e bias algoritmici: sfide per le imprese francesi di fronte all’intelligenza artificiale

- 7 Trasformazione digitale e sfide di protezione dei dati nelle imprese francesi

- 8 Approccio strategico per un’integrazione riuscita dell’IA nelle imprese francesi

Uso inappropriato dell’IA generativa: un esempio allarmante per le imprese francesi

Il primo caso evidenziato dalla DGSI riguarda un’impresa strategica che utilizzava uno strumento di intelligenza artificiale generativa pubblico, sviluppato all’estero, per la traduzione di documenti interni sensibili. L’uso di tale strumento era stato adottato spontaneamente da alcuni collaboratori, attratti dall’efficienza e dalla rapidità che offriva nella gestione quotidiana dei contenuti. Questa pratica, iniziata senza validazione gerarchica né controllo preventivo, ha rapidamente mostrato i suoi limiti quando la direzione informatica ha rilevato una potenziale fuga attraverso un audit interno.

Il ricorso a servizi gratuiti o internazionali presenta un pericolo particolare, poiché i dati inseriti possono essere utilizzati per addestrare i modelli di intelligenza artificiale in background, spesso senza che l’utente ne sia esplicitamente informato. Questo fenomeno rappresenta una minaccia importante per la riservatezza delle informazioni, soprattutto quando i server di queste società si trovano fuori dal territorio francese o europeo, esponendo tali dati a legislazioni straniere con regole talvolta meno rigorose.

Di fronte a questa constatazione, l’impresa ha interrotto l’uso di questo servizio a favore di una soluzione interna e a pagamento, offrendo un ambiente sicuro conforme agli standard nazionali. Inoltre, è stato istituito un gruppo di lavoro specifico per elaborare una dottrina rigorosa sull’uso degli strumenti di IA. Questa iniziativa illustra il bisogno cruciale per le imprese di strutturare l’uso delle tecnologie avanzate per evitare falle di sicurezza. Infatti, le minacce legate all’interconnessione con interfacce esterne o plugin non controllati aumentano il vettore d’attacco e la vulnerabilità a infiltrazioni.

Osservando l’insieme di questo primo esempio, diventa chiaro che la tentazione di ricorrere a strumenti semplici e gratuiti può nascondere rischi considerevoli. Per tutte le imprese francesi che si impegnano nella trasformazione digitale, è imperativo adottare una politica di sicurezza informatica proattiva e integrare la protezione dei dati nei criteri di valutazione degli strumenti IA fin dalle fasi iniziali.

Pericoli della dipendenza dall’IA per le decisioni strategiche nelle imprese francesi

Il secondo caso evidenziato dai servizi di intelligence riguarda uno scenario in cui una società francese in piena espansione internazionale ha esternalizzato una parte critica del suo processo decisionale, la due diligence, a un sistema di intelligenza artificiale progettato all’estero. Questa iniziativa mirava a guadagnare rapidità ed efficacia nella valutazione di potenziali partner commerciali su mercati sconosciuti.

A breve termine, questo automatismo si è dimostrato allettante poiché generava rapporti dettagliati e istantanei. Tuttavia, a causa del volume di lavoro e della carenza di risorse umane specializzate per verificare i risultati, le squadre tendono ad accettare ciecamente i risultati forniti senza ricorrere a una validazione esperta aggiuntiva. Questi sistemi algoritmici forniscono risposte probabilistiche, che corrispondono alla risposta statisticamente più probabile piuttosto che a una risposta priva di bias o perfettamente adatta al contesto.

I bias algoritmici, introdotti fin dalla progettazione del modello o attraverso i dati di addestramento, possono orientare erroneamente i risultati. Inoltre, i famosi « allucinazioni » – generando informazioni errate, imprecise o inventate – mettono in pericolo l’affidabilità di questi strumenti. Questo fenomeno accentua i rischi di decisioni strategiche basate su analisi distorte, che possono causare perdite commerciali, conflitti contrattuali o rottura della fiducia.

L’esempio mostra quindi la necessità cruciale di integrare un controllo umano esperto nei cicli decisionali, per esempio nominando referenti IA incaricati di riformulare, verificare e ponderare le raccomandazioni generate da queste macchine. La vigilanza umana rimane un presidio indispensabile contro la riduzione della diversità di pensiero e le decisioni automatizzate disconnesse dal contesto reale delle imprese francesi.

Questo caso illustra anche un’altra grande sfida tecnologica: come conciliare l’ottimizzazione apportata dall’automazione e dalla trasformazione digitale con il mantenimento di un controllo strategico rigoroso? I programmi di formazione e la sensibilizzazione ai rischi insiti nell’uso dell’intelligenza artificiale diventano essenziali per preservare l’agilità e la resilienza delle imprese in un mercato internazionale competitivo.

Truffe sofisticate via deepfake, una minaccia crescente per le imprese francesi

Il terzo caso menzionato dalla DGSI rivela un tentativo di truffa particolarmente sofisticato che coinvolge l’uso di tecnologie deepfake. Un responsabile di un sito industriale ha ricevuto una chiamata video da un interlocutore che imitava perfettamente l’aspetto e la voce del dirigente del gruppo, richiedendo un bonifico finanziario nell’ambito di un progetto di acquisizione. Questa frode è stata scoperta solo grazie alla vigilanza e all’istinto del responsabile, che ha interrotto rapidamente la comunicazione e allertato la direzione.

Le tecnologie di manipolazione audio e video sono infatti diventate terribilmente convincenti. Tra il 2023 e il 2025, il volume di contenuti deepfake sul web è aumentato più di dieci volte, e milioni di questi video, immagini o registrazioni circolano quotidianamente. Questo sviluppo ha conosciuto un’accelerazione spettacolare anche grazie alla diffusione degli strumenti di IA generativa e delle tecniche di sintesi vocale.

Questi attacchi si basano spesso su una raccolta e un’analisi minuziosa dei dati pubblici e privati di un’impresa per personalizzare i messaggi fraudolenti, rafforzandone così la credibilità e il potenziale di manipolazione. Quasi la metà delle imprese afferma di essere stata presa di mira da questo tipo di tentativo, rivelando l’entità del problema nel panorama francese. Il settore industriale, per la sua forte rilevanza economica, è particolarmente esposto.

Risulta quindi fondamentale per le imprese francesi implementare dispositivi di sicurezza informatica adeguati: formazione dei collaboratori al riconoscimento dei deepfake, istituzione di protocolli di verifica rigorosa durante le richieste finanziarie e ricorso a soluzioni tecnologiche capaci di rilevare contenuti falsificati. Queste misure devono assolutamente accompagnare la trasformazione digitale per evitare che queste innovazioni diventino leve di frode e disinformazione.

Raccomandazioni chiave per incorniciare l’uso dell’intelligenza artificiale nelle imprese francesi

I riscontri della DGSI sottolineano la necessità di un quadro rigoroso per evitare i pericoli identificati, favorendo al contempo l’adozione dell’intelligenza artificiale e i suoi numerosi benefici. Un primo imperativo è la definizione chiara di una politica interna dedicata, che regoli gli usi e i tipi di dati che possono essere trattati tramite strumenti di IA.

Le imprese francesi sono incoraggiate a privilegiare soluzioni locali o europee per limitare i rischi legati alla sovranità dei dati e alla protezione giuridica. Inoltre, la formazione continua dei dipendenti appare un altro pilastro fondamentale, per permettere loro di comprendere le sfide, identificare i rischi e adottare comportamenti conformi alle regole.

La DGSI raccomanda anche di istituire dispositivi di trasparenza interna, in particolare tramite un canale di segnalazione per ogni incidente sospetto, e di stabilire una revisione regolare delle pratiche associate all’intelligenza artificiale. L’integrazione di validazioni umane specializzate deve essere sistematica, in particolare per decisioni strategiche o sensibili.

Infine, la collaborazione tra attori pubblici e privati, comprese le autorità di regolamentazione IA, è essenziale per definire un quadro chiaro e evolutivo, in grado di accompagnare le mutazioni tecnologiche senza compromettere i valori etici e la sicurezza delle imprese francesi.

- Definire una politica interna chiara sull’uso dell’IA

- Preferire soluzioni locali o europee

- Formare regolarmente i collaboratori

- Istaurare un canale di segnalazione degli incidenti

- Garantire una validazione umana sistematica per decisioni critiche

- Assicurare trasparenza e revisione regolare delle pratiche

- Collaborare con le autorità per un quadro regolamentare adeguato

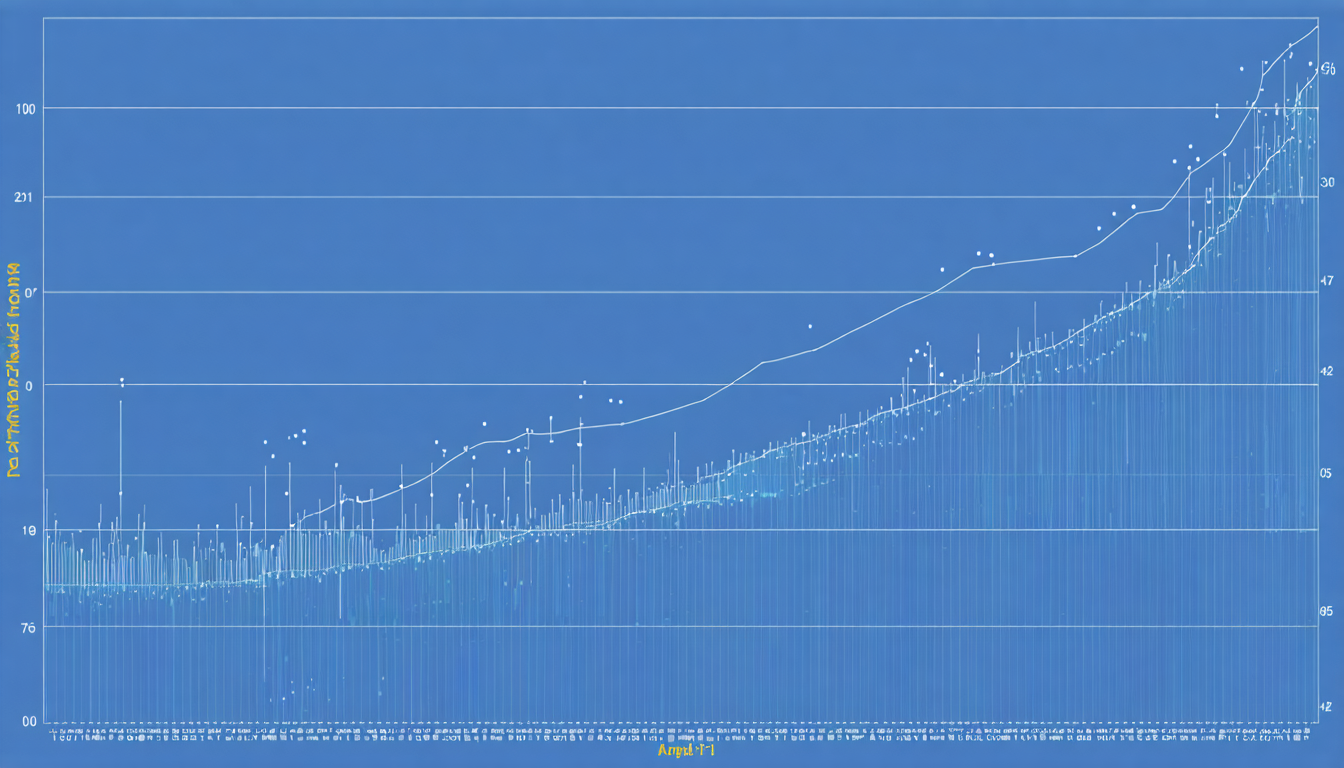

Statistiche e impatti economici dell’intelligenza artificiale nelle imprese francesi

I dati rivelano un panorama contrastante tra benefici economici e potenziali vulnerabilità. Quasi il 78% delle imprese mondiali integra già l’intelligenza artificiale in almeno una delle proprie funzioni. In Francia, questa tendenza è in continua crescita, grazie soprattutto alla trasformazione digitale avviata in molti settori.

Secondo diversi studi, i guadagni di produttività legati all’IA possono raggiungere picchi fino al 55%. La redditività finanziaria media è stimata intorno a 3,70 dollari generati per ogni dollaro investito. Queste prospettive economiche attraggono i dirigenti, ma talvolta nascondono i rischi intrinseci, in particolare in materia di sicurezza informatica e rispetto della privacy.

Questa tabella sintetizza alcuni indicatori chiave:

| Indicatore | Valore | Commenti |

|---|---|---|

| Tasso di adozione IA in azienda (Francia) | 70% | In forte aumento dal 2023 |

| Guadagni di produttività legati all’IA | Fino al 55% | Variabilità a seconda di settore e uso |

| Ritorno finanziario medio | 3,70 $ per ogni dollaro investito | Vantaggio significativo rispetto agli investimenti tradizionali |

| Imprese senza politica IA formale | 1/3 | Mancanza di governance che espone a rischi |

| Imprese bersaglio di deepfake | 46% | Diffusione rapida di questa minaccia |

Rischi etici e bias algoritmici: sfide per le imprese francesi di fronte all’intelligenza artificiale

Al di là delle questioni di sicurezza e protezione dei dati, le imprese francesi si confrontano con una sfida fondamentale legata ai bias algoritmici. Questi bias si manifestano quando i dati usati per addestrare i modelli sono parzialmente rappresentativi o quando pregiudizi impliciti si inseriscono nei programmi. Ciò può generare discriminazioni, falsare i risultati delle analisi o compromettere la presa di decisioni automatizzate.

I rischi etici legati a questi bias sono cruciali, soprattutto per le imprese che operano in settori sensibili quali finanza, sanità o risorse umane. Ad esempio, un’IA con bias può influenzare ingiustamente decisioni di reclutamento, penalizzare alcuni profili di clienti oppure favorire scelte commerciali discutibili.

Per affrontare queste sfide, le imprese devono implementare audit regolari sugli algoritmi, realizzare test di conformità etica e rafforzare la diversità dei team di sviluppo per limitare gli angoli ciechi. La sensibilizzazione dei decisori a questi rischi e l’integrazione di meccanismi correttivi sono anche essenziali.

Infine, la regolamentazione IA a livello europeo impone ora requisiti rigorosi in materia di valutazione dei bias e trasparenza, obbligando le imprese francesi a conformarsi a questi standard sotto pena di sanzioni legali e impatti negativi sulla loro immagine.

Misure pratiche per ridurre i bias algoritmici

- Effettuare audit indipendenti sui modelli utilizzati

- Coinvolgere esperti multidisciplinari nello sviluppo degli algoritmi

- Usare set di dati rappresentativi e diversificati

- Mettere in atto meccanismi di spiegabilità delle decisioni algoritmiche

- Formare i team ai rischi etici legati alle IA

Trasformazione digitale e sfide di protezione dei dati nelle imprese francesi

La trasformazione digitale, accelerata dall’uso intensivo dell’intelligenza artificiale, impone un rafforzamento delle politiche di protezione dei dati. In questo contesto, le imprese francesi devono rispettare non solo le norme europee del GDPR, ma anche anticipare le esigenze specifiche relative a riservatezza e integrità dei dati trattati da sistemi IA.

La manipolazione di dati sensibili tramite interfacce automatizzate può aggravare i rischi di fughe e usi impropri. Pertanto, una politica di cybersicurezza rafforzata deve coniugare l’uso di strumenti tecnici con una governance rigorosa, includendo la definizione di ruoli chiari e la responsabilizzazione degli attori.

La sicurezza dei dati passa anche dal controllo dei flussi verso l’esterno. Le imprese francesi sono incoraggiate a limitare gli scambi con piattaforme esterne non certificate o situate fuori dall’Unione Europea, privilegiando soluzioni sovrane che garantiscano un maggiore controllo sui dati. Questo approccio contribuisce a preservare la fiducia di clienti e partner, fattore chiave per consolidare relazioni commerciali a lungo termine.

Approccio strategico per un’integrazione riuscita dell’IA nelle imprese francesi

Infine, per massimizzare le possibilità di successo della trasformazione digitale e ridurre i rischi, le imprese francesi devono adottare un approccio strategico globale e integrato. Questo mobilita non solo le tecnologie di intelligenza artificiale, ma anche la formazione delle squadre, la revisione dei processi aziendali e l’istituzione di una gestione della sicurezza e conformità.

Una governance adeguata dell’IA include la nomina di responsabili dedicati, l’adozione di codici etici e la stretta collaborazione con le autorità regolatorie. Questo quadro deve favorire anche l’innovazione garantendo un uso responsabile e trasparente.

La storia di queste tre imprese illustra che l’innovazione non può prescindere dalla vigilanza. Lo sviluppo delle competenze interne, la sensibilizzazione ai rischi e la trasparenza sulle pratiche autorizzate assicurano un equilibrio tra lo sfruttamento del potenziale dell’IA e il controllo dei pericoli connessi.