En el contexto actual marcado por una adopción rápida y generalizada de la inteligencia artificial en las empresas francesas, los beneficios son innegables: mejora de la productividad, transformación digital acelerada y automatización de numerosas tareas. Sin embargo, este desarrollo viene acompañado de riesgos significativos, a veces desconocidos o minimizados, que pueden debilitar la seguridad, la confidencialidad e incluso la sostenibilidad de las organizaciones. La Dirección General de Seguridad Interior (DGSI) ha publicado recientemente un Flash de injerencia que destaca estas fragilidades a través de tres casos reales vividos por empresas francesas, reveladores de los peligros que acechan cuando no se domina plenamente las herramientas de inteligencia artificial empleadas.

Estos ejemplos exponen diversas facetas de los desafíos tecnológicos y organizativos: por una parte, la manipulación de datos sensibles mediante herramientas externas no controladas; por otra, la confianza excesiva otorgada a sistemas de decisión autónomos; y finalmente, el aumento de ataques sofisticados que utilizan tecnologías deepfake. Este artículo se adentra en estas tres ilustraciones concretas para profundizar en los principales desafíos que enfrentan las empresas francesas en su exploración y uso de la inteligencia artificial, abordando los riesgos éticos, los sesgos algorítmicos, las problemáticas de protección de datos y los imperativos de seguridad informática. También se evaluará cómo una regulación adecuada de la IA, combinada con una gobernanza rigurosa, puede prevenir errores costosos y preservar la integridad de las estructuras económicas nacionales.

- 1 Uso inapropiado de la IA generativa: un ejemplo alarmante para las empresas francesas

- 2 Peligros de la dependencia a la IA para la toma de decisiones estratégicas en las empresas francesas

- 3 Estafas sofisticadas por deepfake, una amenaza creciente para las empresas francesas

- 4 Recomendaciones clave para enmarcar el uso de la inteligencia artificial en las empresas francesas

- 5 Estadísticas e impactos económicos de la inteligencia artificial en las empresas francesas

- 6 Riesgos éticos y sesgos algorítmicos: desafíos para las empresas francesas frente a la inteligencia artificial

- 7 Transformación digital y desafíos de protección de datos en las empresas francesas

- 8 Enfoque estratégico para una integración exitosa de la IA en las empresas francesas

Uso inapropiado de la IA generativa: un ejemplo alarmante para las empresas francesas

El primer caso destacado por la DGSI concierne a una empresa estratégica que utilizaba una herramienta pública de inteligencia artificial generativa, desarrollada en el extranjero, para la traducción de documentos internos sensibles. El uso de esta herramienta había sido adoptado de forma espontánea por algunos colaboradores, atraídos por la eficacia y rapidez que ofrecía en la gestión diaria de contenidos. Esta práctica, iniciada sin validación jerárquica ni control previo, reveló rápidamente sus límites cuando la dirección informática detectó una posible fuga mediante una auditoría interna.

El recurso a servicios gratuitos o internacionales presenta un peligro particular, ya que los datos ingresados pueden ser usados para entrenar los modelos de inteligencia artificial en segundo plano, a menudo sin que el usuario sea informado explícitamente. Este fenómeno representa una amenaza mayor para la confidencialidad de la información, especialmente cuando los servidores de estas empresas están situados fuera del territorio francés e incluso europeo, exponiendo esos datos a legislaciones extranjeras cuyas reglas a veces son menos estrictas.

Ante esta constatación, la empresa cesó el uso de este servicio en favor de una solución interna y de pago, que ofrece un entorno seguro conforme a las normas nacionales. Además, se estableció un grupo de trabajo específico para elaborar una doctrina rigurosa sobre el uso de herramientas de IA. Este enfoque ilustra la necesidad crucial para las empresas de estructurar el uso de tecnologías avanzadas para evitar fallas de seguridad. En efecto, las amenazas vinculadas a la interconexión con interfaces externas o plugins no controlados aumentan el vector de ataque y la vulnerabilidad a infiltraciones.

Al observar en su conjunto este primer ejemplo, queda claro que la tentación de recurrir a herramientas simples y gratuitas puede ocultar riesgos considerables. Para todas las empresas francesas que se comprometen con la transformación digital, es imperativo adoptar una política de seguridad informática proactiva e integrar la protección de datos en los criterios de evaluación de las herramientas de IA desde las fases iniciales.

Peligros de la dependencia a la IA para la toma de decisiones estratégicas en las empresas francesas

El segundo caso señalado por los servicios de inteligencia describe un escenario en el que una empresa francesa en plena expansión internacional externalizó una parte crítica de su proceso de decisión, la due diligence, a un sistema de inteligencia artificial diseñado en el extranjero. Esta medida tenía como objetivo ganar rapidez y eficiencia en la evaluación de socios comerciales potenciales en mercados desconocidos.

A corto plazo, esta automatización resultó atractiva ya que generaba informes detallados e instantáneos. Sin embargo, debido al volumen de trabajo y a la falta de recursos humanos especializados para verificar los resultados, los equipos tienden a aceptar ciegamente los resultados proporcionados sin recurrir a una validación experta adicional. Pero estos sistemas algorítmicos ofrecen respuestas probabilísticas, que corresponden a la respuesta más estadísticamente probable en lugar de una respuesta libre de sesgos o perfectamente adaptada al contexto.

Los sesgos algorítmicos, introducidos desde el diseño del modelo o a través de los datos de entrenamiento, pueden orientar incorrectamente los resultados. Por otra parte, las famosas « alucinaciones » —que generan información errónea, imprecisa o inventada— ponen en peligro la fiabilidad de estas herramientas. Este fenómeno acentúa los riesgos de toma de decisiones estratégicas basadas en análisis sesgados, lo que puede conducir a pérdidas comerciales, conflictos contractuales o una ruptura de confianza.

El ejemplo muestra, por tanto, la necesidad crucial de integrar un control humano experto en los ciclos decisorios, por ejemplo nombrando referentes de IA encargados de reformular, verificar y ponderar las recomendaciones generadas por estas máquinas. La vigilancia humana sigue siendo un salvaguarda indispensable contra la reducción de la diversidad de pensamiento y las decisiones automatizadas desconectadas del contexto real de las empresas francesas.

Este caso también ilustra otro desafío tecnológico importante: ¿cómo conjugar la optimización aportada por la automatización y la transformación digital con el mantenimiento de un control estratégico riguroso? Los programas de formación y la sensibilización a los riesgos inherentes al uso de la inteligencia artificial se vuelven esenciales para preservar la agilidad y la resiliencia de las empresas en un mercado internacional competitivo.

Estafas sofisticadas por deepfake, una amenaza creciente para las empresas francesas

El tercer caso mencionado por la DGSI revela un intento de estafa particularmente sofisticado que implica el uso de tecnologías deepfake. Un responsable de un sitio industrial recibió una llamada de vídeo de un interlocutor que imitaba perfectamente la apariencia y la voz del dirigente del grupo, solicitando una transferencia financiera en el marco de un proyecto de adquisición. Esta engaño fue detectado solamente gracias a la vigilancia y al instinto del responsable, que rápidamente interrumpió la comunicación y alertó a la dirección.

Las tecnologías de manipulación audiovisual se han vuelto efectivamente muy convincentes. Entre 2023 y 2025, el volumen de contenidos deepfake en internet se multiplicó por más de diez, y varios millones de estos vídeos, imágenes o grabaciones circulan diariamente. Este desarrollo ha experimentado una aceleración espectacular debido también a la popularización de herramientas de IA generativa y técnicas de síntesis de voz.

Estos ataques suelen basarse en una recopilación y análisis minucioso de datos públicos y privados de una empresa para personalizar los mensajes fraudulentos, reforzando así su credibilidad y su potencial de manipulación. Cerca de la mitad de las empresas afirman haber sido objetivo de este tipo de intento, revelando la magnitud del problema en el panorama francés. El sector industrial, por su fuerte importancia económica, está particularmente expuesto.

Así, resulta fundamental para las empresas francesas desplegar dispositivos de seguridad informática adecuados: formación de los colaboradores en el reconocimiento de deepfakes, establecimiento de protocolos estrictos de verificación durante solicitudes financieras y uso de soluciones tecnológicas capaces de detectar contenidos falsificados. Estas medidas deben acompañar obligatoriamente la transformación digital para evitar que estas innovaciones se conviertan en palancas de fraude y desinformación.

Recomendaciones clave para enmarcar el uso de la inteligencia artificial en las empresas francesas

Los informes de la DGSI insisten en la necesidad de un encuadre riguroso para evitar los peligros identificados, al tiempo que se fomenta la adopción de la inteligencia artificial y sus numerosos beneficios. Un primer imperativo es la definición clara de una política interna dedicada, que regule los usos y los tipos de datos que pueden ser tratados mediante herramientas de IA.

Se anima a las empresas francesas a privilegiar soluciones locales o europeas para limitar los riesgos relacionados con la soberanía de los datos y la protección jurídica. Por otra parte, la formación continua de los empleados aparece como otro pilar fundamental, permitiéndoles comprender los desafíos, identificar los riesgos y adoptar comportamientos conforme a las reglas.

La DGSI también recomienda implementar dispositivos de transparencia interna, especialmente a través de un canal de denuncia para cualquier incidente sospechoso, e instaurar una revisión regular de las prácticas asociadas a la inteligencia artificial. La integración de validaciones humanas especializadas debe ser sistemática, particularmente para decisiones estratégicas o sensibles.

Finalmente, la colaboración entre actores públicos y privados, incluidas las autoridades reguladoras de la IA, es esencial para definir un marco claro y evolutivo, capaz de acompañar las transformaciones tecnológicas sin comprometer los valores éticos y la seguridad de las empresas francesas.

- Definir una política interna clara sobre el uso de la IA

- Preferir soluciones locales o europeas

- Formar regularmente a los colaboradores

- Establecer un canal de denuncia de incidentes

- Garantizar una validación humana sistemática para las decisiones críticas

- Asegurar la transparencia y la revisión regular de prácticas

- Colaborar con las autoridades para un marco regulatorio adaptado

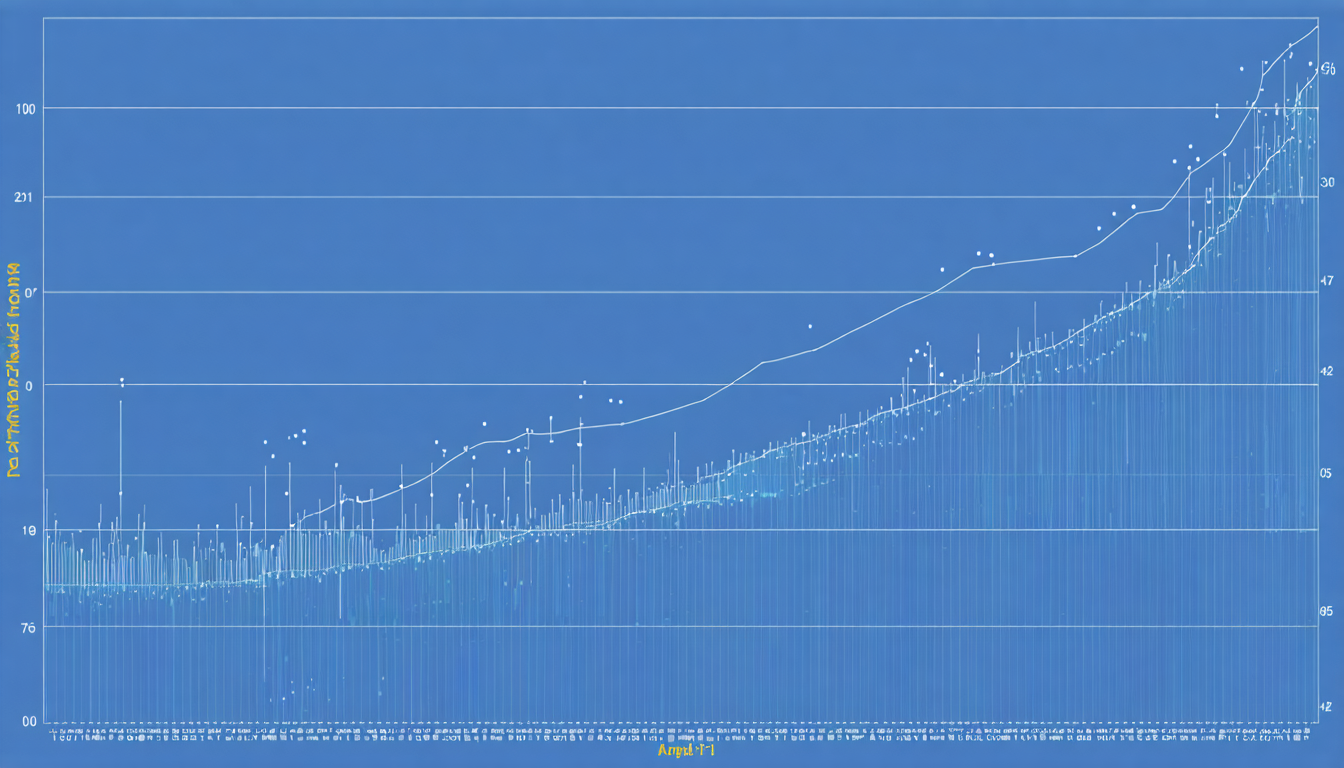

Estadísticas e impactos económicos de la inteligencia artificial en las empresas francesas

Las cifras revelan un panorama contrastado entre los beneficios económicos y las vulnerabilidades potenciales. Cerca del 78 % de las empresas mundiales integran ya la inteligencia artificial en al menos una de sus funciones. En Francia, esta tendencia está en constante progresión, gracias principalmente a la transformación digital impulsada en numerosos sectores.

Según varios estudios, las ganancias de productividad vinculadas a la IA pueden alcanzar picos de hasta un 55 %. La rentabilidad financiera media se estima en aproximadamente 3,70 dólares generados por cada dólar invertido. Estas perspectivas económicas atraen a los dirigentes, pero a veces ocultan los riesgos intrínsecos, especialmente en materia de seguridad informática y respeto a la privacidad.

Esta tabla sintetiza algunos indicadores clave:

| Indicador | Valor | Comentarios |

|---|---|---|

| Tasa de adopción de IA en las empresas (Francia) | 70% | En fuerte aumento desde 2023 |

| Ganancias de productividad vinculadas a la IA | Hasta 55% | Variabilidad según sector y uso |

| Retorno financiero medio | 3,70 $ por cada dólar invertido | Ventaja significativa sobre inversiones tradicionales |

| Empresas sin política formal de IA | 1/3 | Falta de gobernanza que expone a riesgos |

| Empresas objetivo de deepfakes | 46% | Difusión rápida de esta amenaza |

Riesgos éticos y sesgos algorítmicos: desafíos para las empresas francesas frente a la inteligencia artificial

Más allá de las cuestiones de seguridad y protección de datos, las empresas francesas se enfrentan a un desafío fundamental relacionado con los sesgos algorítmicos. Estos sesgos ocurren cuando los datos utilizados para entrenar los modelos son parcialmente representativos o cuando prejuicios implícitos se insertan en los programas. Esto puede generar discriminaciones, distorsionar los resultados del análisis o comprometer la toma de decisiones automatizada.

Los riesgos éticos vinculados a estos sesgos son cruciales, especialmente para empresas que operan en sectores sensibles como finanzas, salud o recursos humanos. Por ejemplo, una IA sesgada puede influir injustamente en decisiones de reclutamiento, penalizar ciertos perfiles de clientes o favorecer elecciones comerciales discutibles.

Para afrontar estos desafíos, las empresas deben implementar auditorías regulares de los algoritmos, realizar pruebas de conformidad ética y reforzar la diversidad de los equipos de desarrollo para limitar los puntos ciegos. La sensibilización de los tomadores de decisiones sobre estos riesgos y la integración de mecanismos correctivos también son esenciales.

Finalmente, la regulación de la IA a escala europea impone ahora exigencias estrictas en materia de evaluación de sesgos y transparencia, lo que obliga a las empresas francesas a cumplir estos estándares bajo pena de sanciones legales e impacto negativo en su imagen.

Medidas prácticas para reducir los sesgos algorítmicos

- Realizar auditorías independientes sobre los modelos utilizados

- Involucrar expertos multidisciplinarios en el desarrollo de los algoritmos

- Utilizar conjuntos de datos representativos y diversos

- Implementar mecanismos de explicabilidad de las decisiones algorítmicas

- Formar a los equipos sobre los riesgos éticos relacionados con las IA

Transformación digital y desafíos de protección de datos en las empresas francesas

La transformación digital, acelerada por el uso intensivo de la inteligencia artificial, impone un refuerzo de las políticas de protección de datos. En este contexto, las empresas francesas deben respetar no solo las normas europeas del RGPD, sino también anticipar las exigencias específicas relativas a la confidencialidad e integridad de los datos tratados por sistemas de IA.

La manipulación de datos sensibles mediante interfaces automatizadas puede agravar los riesgos de fugas y uso indebido. Por lo tanto, una política de ciberseguridad reforzada debe combinar el empleo de herramientas técnicas y una gobernanza rigurosa, incluyendo la definición de roles claros y la responsabilización de los actores.

La securización de los datos también pasa por el control de los flujos con el exterior. Se anima a las empresas francesas a limitar el intercambio con plataformas externas no certificadas o ubicadas fuera de la Unión Europea, privilegiando soluciones soberanas que garanticen un control incrementado sobre los datos. Este enfoque contribuye a preservar la confianza de clientes y socios, factor clave en la consolidación de relaciones comerciales a largo plazo.

Enfoque estratégico para una integración exitosa de la IA en las empresas francesas

Finalmente, para maximizar las probabilidades de éxito de la transformación digital y minimizar los riesgos, las empresas francesas deben adoptar un enfoque estratégico global e integrado. Este moviliza no solo las tecnologías de inteligencia artificial, sino también la formación de los equipos, la revisión de los procesos de negocio, así como la implementación de una gobernanza de la seguridad y la conformidad.

Una gobernanza adaptada de la IA incluye la designación de responsables dedicados, la implementación de códigos de ética y la colaboración estrecha con las autoridades regulatorias. Este marco también debe fomentar la innovación al tiempo que garantiza un uso responsable y transparente.

La historia de estas tres empresas ilustra que la innovación no va sin vigilancia. El desarrollo de competencias internas, la sensibilización a los riesgos y la transparencia sobre las prácticas autorizadas aseguran un equilibrio entre la explotación del potencial de la IA y el control de los peligros inherentes.