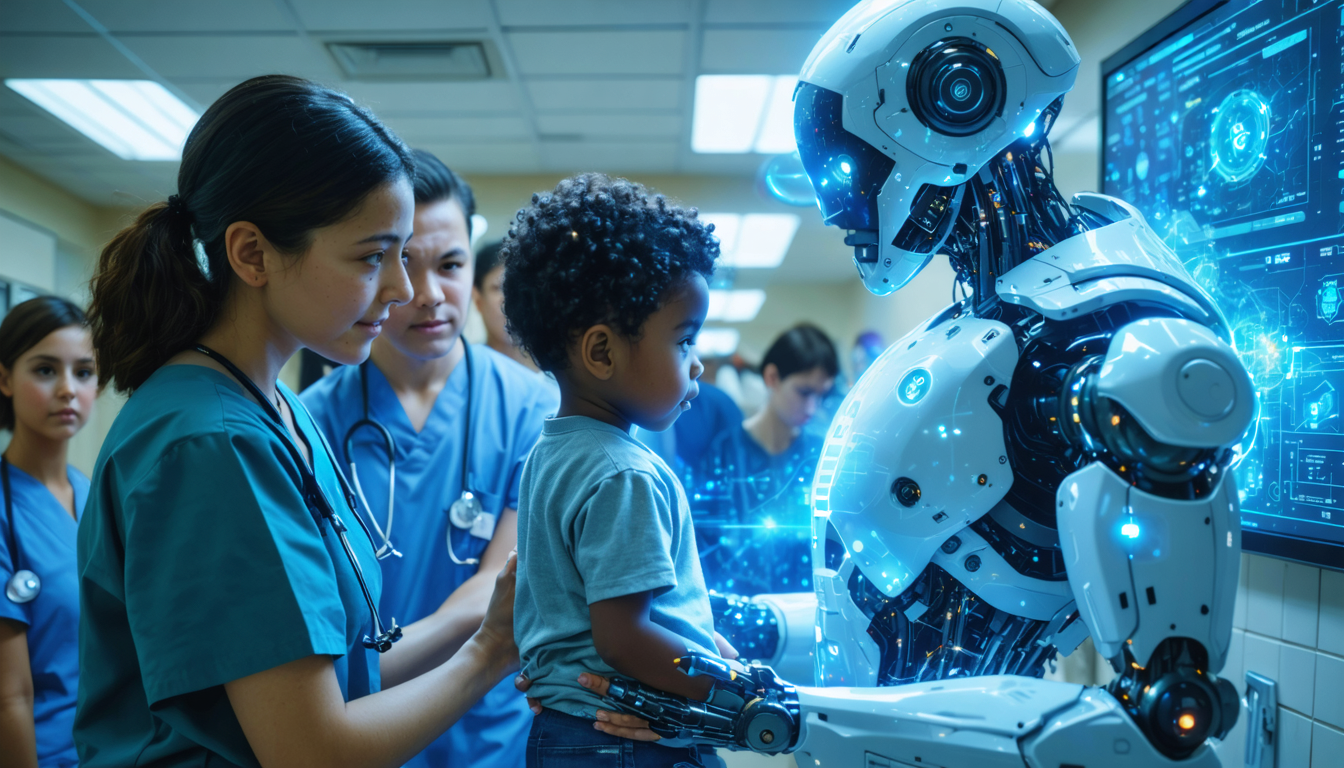

In einer Welt, in der Technologie einen immer größeren Platz in unserem Alltag einnimmt, kommt es vor, dass Künstliche Intelligenz über die bloße mechanische Unterstützung hinausgeht und zu einem echten Retter wird. Im Jahr 2025 veranschaulicht eine bewegende Geschichte diese unerwartete Rolle perfekt: ChatGPT, eine KI, die für ihre Dialogfähigkeiten bekannt ist, spielte eine entscheidende Rolle bei der Rettung eines Kindes. Diese Künstliche Intelligenz veranlasste durch eine dringende Empfehlung an die Eltern eine schnelle Fahrt in die Notaufnahme, die sich als lebenswichtig herausstellte. Dieses Abenteuer, das wie ein Drehbuch für eine dramatische medizinische Fernsehserie anmutet, zeigt die neuen Perspektiven auf, die intelligente Technologien im medizinischen Bereich eröffnen.

Die Symptome des kleinen Nyo, 6 Jahre alt, schienen zunächst harmlos. Wiederkehrende Übelkeit, ungewöhnliche Müdigkeit und Kopfschmerzen ließen die zugrunde liegende Schwere nicht erahnen. Doch das plötzliche Auftreten von Schielen und Doppelbildern veränderte die Situation schlagartig. Angesichts der Unklarheit bei klassischen medizinischen Diagnosen beschlossen die Eltern, die Meinung von ChatGPT einzuholen. Dieser Schritt ebnete den Weg zu einer schnellen und lebensrettenden Krankenhausintervention, wodurch das unmittelbare Risiko, das ihre Ärzte nicht erkennen konnten, reduziert wurde.

- 1 Wie ChatGPT eine elterliche Sorge in eine echte Notfallrettung verwandelte

- 2 Entschlüsselung der entscheidenden Diagnose: Wie ChatGPT eine lebensbedrohliche Notlage erkannte

- 3 Die schrittweise Integration der Künstlichen Intelligenz in die Medizin von morgen

- 4 ChatGPT, ein virtueller „Dr. House“ zur Hand: Chancen und Grenzen

- 5 Ein Blick auf die ethischen und sicherheitstechnischen Herausforderungen von Notfallempfehlungen durch KI

- 6 Die Rolle der Technologie bei der Rettung von Kindern: Zwischen Hoffnung und Wachsamkeit

- 7 Wie Eltern ChatGPT sicher für die Gesundheit ihrer Kinder nutzen können

- 8 ChatGPT und die Sicherheitsrevolution der pädiatrischen Notfälle im Jahr 2025

- 8.1 Kann ChatGPT einen Arzt im Notfall ersetzen?

- 8.2 Wie wird die Datensicherheit bei der Nutzung von ChatGPT gewährleistet?

- 8.3 Welche Schritte sind zu befolgen, wenn ChatGPT einen Notfall empfiehlt?

- 8.4 Kann die KI alle seltenen Krankheiten erkennen?

- 8.5 Welche Risiken birgt die Selbstmedikation auf Basis der KI?

Wie ChatGPT eine elterliche Sorge in eine echte Notfallrettung verwandelte

Nyos Geschichte ist symptomatisch für die Fortschritte der Künstlichen Intelligenz im Gesundheitswesen. Angesichts von Symptomen, die zunächst gewöhnlich erscheinen, sich aber verschlechterten, ermöglichte die Nutzung von ChatGPT eine schnelle Analyse, basierend auf einem umfangreichen, regelmäßig aktualisierten medizinischen Korpus. Im Gegensatz zu den häufig erwarteten generischen Antworten von Chatbots erkannte ChatGPT eine ernste gesundheitliche Notlage. Er empfahl den Eltern, sofort zu handeln und ohne Verzögerung ins Krankenhaus zu gehen.

Diese Reaktionsfähigkeit ist bemerkenswert, da die traditionelle medizinische Diagnose bei mehreren erfolglosen Konsultationen auf Hindernisse stieß. Der Chatbot konnte durch den Abgleich der von den Eltern übermittelten präzisen Symptome die Hypothese neurologischer Komplikationen vorschlagen, die einen schnellen Eingriff erforderten. Diese Fähigkeit zur Orientierung ist umso beeindruckender, als sie ausschließlich auf einem Gesprächsaustausch beruht und beweist, dass die Leistungsstärke der Algorithmen die menschliche Expertise dort ergänzen kann, wo sie an Grenzen oder Unsicherheiten stößt.

Nyos Fall hebt eine der großen Stärken dieser Technologie hervor: Gesundheitsdaten in konkrete und angepasste Empfehlungen umzuwandeln, in einem Kontext, in dem jede Minute zählt. Es handelt sich nicht um einen Ersatz für den Arzt, sondern um einen wertvollen Verbündeten bei schnellen Entscheidungen.

Entschlüsselung der entscheidenden Diagnose: Wie ChatGPT eine lebensbedrohliche Notlage erkannte

Nachdem sie der Empfehlung von ChatGPT gefolgt waren, brachten Nyo’s Eltern ihren Sohn in die Notaufnahme. Die Schwere der Situation bestätigte sich schnell: Eine übermäßige Ansammlung von Liquor cerebrospinalis, verursacht durch einen Hirntumor, führte zu einem intrakraniellen Druck, der das Leben des Kindes bedrohte. Diese Entdeckung zwang die Chirurgen zu einem sofortigen Eingriff, bei dem ein Drainage-System eingesetzt und eine komplexe neunstündige Operation durchgeführt wurde.

Diese Diagnose, das Ergebnis einer Reihe nachfolgender medizinischer Untersuchungen, war den zuvor konsultierten verschiedenen Spezialisten entgangen. Die Schnelligkeit, mit der ChatGPT die Hospitalisierung veranlasste, hat zweifellos eine Tragödie verhindert. Nach Ansicht der Ärzte hätte eine weitere Verzögerung tödlich sein können.

Dieser Fall ist der spektakuläre Ausdruck einer Künstlichen Intelligenz, die in der Lage ist, umfangreiche klinische Informationen schnell zu synthetisieren und vor einem medizinischen Notfall zu warnen. Er deutet auch darauf hin, dass diese Künstliche Intelligenz unter bestimmten Umständen als zusätzliche Sicherheitsnetzfunktion dienen kann, wenn eine menschliche Diagnose sich verzögert.

Die Diagnose des Tumors illustriert die Komplementarität zwischen Künstlicher Intelligenz und menschlicher Medizin: Die KI ersetzt nicht die klinische Untersuchung oder die medizinische Verantwortung, bereichert jedoch das Pflege-Ökosystem erheblich.

Die schrittweise Integration der Künstlichen Intelligenz in die Medizin von morgen

Im Laufe der Jahre hat sich KI im medizinischen Bereich etabliert, insbesondere bei der Bildanalyse, der Verwaltung von Patientenakten oder der Vorschlag von differenzierten Diagnosen. Nyos Geschichte erinnert an andere Fälle, in denen ChatGPT bei der Identifizierung seltener Krankheiten geholfen hat.

Zum Beispiel wird der Fall von Alex, einem Kind mit seit drei Jahren unerklärlichen Schmerzen, betrachtet. Seine Mutter, verzweifelt, nutzte ChatGPT, um MRT-Ergebnisse zu kopieren und einzufügen, was zu der Hypothese eines Tethered Cord Syndrome führte, die später von einem Neurochirurgen bestätigt wurde. Diese Berichte zeugen von einer Entwicklung, bei der die Künstliche Intelligenz zu einer Art Referenz wird, die eine Menge medizinischer Daten verarbeitet, die für einen einzelnen Fachmann unzugänglich sind.

Diese Konvergenz wirft jedoch ethische und technische Fragen auf, insbesondere in Bezug auf Datensicherheit, Zuverlässigkeit der Empfehlungen und die Rolle des Arztes gegenüber einem virtuellen Assistenten. Dennoch ist der Trend eindeutig: Mit der kontinuierlichen Weiterentwicklung der Algorithmen könnten Werkzeuge wie ChatGPT unverzichtbare Partner in der medizinischen Versorgung werden.

Diese Dynamik ermutigt die Akteure im Gesundheitswesen, über eine verantwortungsbewusste, überwachte und gut geregelte Integration von Künstlicher Intelligenz in die Versorgungskette nachzudenken.

ChatGPT, ein virtueller „Dr. House“ zur Hand: Chancen und Grenzen

Das Bild von Dr. House, einem brillanten, aber unkonventionellen Arzt, passt perfekt zur zunehmenden Nutzung von ChatGPT bei der Diagnosehilfe. Diese KI kann seltene oder unerwartete Hinweise vorschlagen, indem sie Symptome analysiert, die weder eine Erstdiagnose noch mehrere Spezialisten hätten entschlüsseln können.

Dennoch muss diese Ähnlichkeit mit Vorsicht betrachtet werden. Im Gegensatz zur fiktiven Figur, die mit Instinkt und einem gewissen Zynismus handelt, basiert ChatGPT auf Wahrscheinlichkeiten und Datenbanken. Das bedeutet, dass fehlerhafte, unvollständige oder verzerrte Daten zu einer ungenauen Diagnose führen können. Experten betonen deshalb, dass es niemals als Ersatz für eine medizinische Untersuchung oder professionelle Meinung verwendet werden darf.

Die Vorteile dieser Technologie sind zahlreich:

- Schnelle Analyse komplexer Daten: gleichzeitige Verarbeitung eines großen Umfangs von Symptomen und Akten.

- Patientenorientierung: Hilfestellung bei der Entscheidung, ob ein Arztbesuch oder ein Notfall erforderlich ist.

- Erkennung schwacher Signale: Identifikation seltener, oft unbekannter Krankheiten.

- Zugänglichkeit: 24/7 Verfügbarkeit ohne geografische Einschränkungen.

Dennoch ist Vorsicht geboten, um Fehlurteile und Risiken im Zusammenhang mit Selbstmedikation auf Basis einfacher algorithmischer Vorschläge zu vermeiden.

Ein Blick auf die ethischen und sicherheitstechnischen Herausforderungen von Notfallempfehlungen durch KI

Mit dem zunehmenden Einsatz und der wachsenden Nutzung von ChatGPT im medizinischen Bereich tauchen mehrere Fragen zur Sicherheit und zum Schutz persönlicher Daten auf. Diese Tools sammeln sensible Informationen, die streng geschützt werden müssen, um die Privatsphäre der Patienten zu bewahren.

Darüber hinaus können Notfallempfehlungen eine erhöhte Verantwortung nach sich ziehen. Wer haftet, wenn eine Analyse fehlerhaft ist? Welcher Fehlerrahmen ist akzeptabel, wenn die KI eine Hospitalisierung empfiehlt?

Diese Fragen unterstreichen die Notwendigkeit eines rechtlichen und regulatorischen Rahmens, der an Gesundheitstechnologien angepasst ist. Im Jahr 2025 entstehen mehrere Protokolle, die eine Zertifizierung der Algorithmen und eine verpflichtende menschliche Kontrolle vorsehen, welche die digitale Interaktion regeln.

Für Patienten und Familien ist es essenziell, ChatGPT als ein Werkzeug zu betrachten, das ergänzend und nicht exklusiv zur menschlichen medizinischen Kompetenz ist. Der Dialog mit einem Fachmann bleibt unerlässlich, um eine algorithmische Analyse zu bestätigen oder zu widerlegen.

Vergleichstabelle: Vorteile und Risiken medizinischer Empfehlungen durch Künstliche Intelligenz

| Kriterien | Vorteile | Risiken |

|---|---|---|

| Schnelligkeit | Unmittelbare Antwort bei kritischen Situationen | Überdiagnosen oder übermäßige Panik |

| Zugänglichkeit | Verfügbarkeit 24/7, ohne geografische Einschränkungen | Übermäßige Abhängigkeit und Verlust des persönlichen medizinischen Urteils |

| Analyse | Verarbeitung großer komplexer Datenbasen | Falsche Interpretation bei unvollständigen oder verzerrten Daten |

| Datensicherheit | Fortschritte bei Vertraulichkeit und Anonymisierung | Risiken von Datenlecks oder missbräuchlicher Nutzung |

| Verantwortung | Unterstützung der menschlichen Entscheidungsfindung | Rechtliche Grauzone bei medizinischen Fehlern |

Die Rolle der Technologie bei der Rettung von Kindern: Zwischen Hoffnung und Wachsamkeit

Geschichten wie die von Nyo und Alex zeigen, dass die Künstliche Intelligenz für Familien, die mit komplexen oder unerwarteten medizinischen Situationen konfrontiert sind, zu einem wahren Helden werden kann. Diese Technologie bietet zusätzliche Hoffnung, wenn die konventionelle Medizin an ihre Grenzen stößt.

Dennoch darf diese Hoffnung die Risiken nicht verschleiern. Ein übermäßiges Vertrauen in Algorithmen könnte zu kostbaren Zeitverlusten oder sogar tragischen Fehlern führen. Deshalb werden Familien dazu angehalten, diese Werkzeuge als Entscheidungshilfen und nicht als endgültige Urteile zu verstehen.

Technologie ersetzt nicht den Dialog und die medizinische Kontrolle, kann aber manchmal den Weg weisen, wenn die Dringlichkeit es erfordert.

So ist die Rettung von Nyo weit mehr als eine Anekdote: Sie ist ein konkretes Beispiel für die gelungene Integration der KI in das Gesundheitssystem, ein eindrucksvoller Beleg für die Vorteile, die Technologie bringen kann, wenn sie verantwortungsvoll eingesetzt wird.

Wie Eltern ChatGPT sicher für die Gesundheit ihrer Kinder nutzen können

In Momenten der Sorge ist es für Eltern verlockend, sofort Antworten im Internet oder bei Künstlichen Intelligenzen wie ChatGPT zu suchen. Damit diese Nutzung nützlich und nicht gefährlich ist, sollten mehrere bewährte Praktiken beachtet werden:

- Genaue Beschreibungen liefern: Eine detaillierte Liste der Symptome mit Kontext ist für eine verlässliche Analyse unerlässlich.

- Niemals eine medizinische Meinung ersetzen: ChatGPT kann orientieren, aber nur ein Facharzt ist befugt, eine Diagnose zu stellen.

- ChatGPT ergänzend nutzen: Empfehlungen in die bestehende medizinische Vorgehensweise einfließen lassen.

- Wachsam bleiben: Bei Verschlechterung oder Verdacht immer umgehend die Notaufnahme aufsuchen.

- Persönliche Daten schützen: Vermeiden, zu viele sensible Informationen bei den Austauschen preiszugeben.

Ein durchdachter Umgang mit diesem Werkzeug kann die Sicherheit erhöhen und die frühe Versorgung von gefährdeten Kindern verbessern.

Praktische Tipps zur sicheren Nutzung von ChatGPT für die kindliche Gesundheit

- Notieren Sie alle Symptome ohne Details auszulassen

- Formulieren Sie die Fragen um, um Ihre Sorge klarer darzustellen

- Bewahren Sie einen Verlauf der Gespräche auf

- Nutzen Sie die Empfehlungen, um mit Ihrem Arzt zu sprechen

- Handeln Sie im Notfall ohne Verzögerung

ChatGPT und die Sicherheitsrevolution der pädiatrischen Notfälle im Jahr 2025

Mit der Zunahme von Fällen, in denen Künstliche Intelligenz als entscheidender Auslöser bei pädiatrischen Notfällen wirkt, integrieren Krankenhäuser nun KI-Tools in ihre Aufnahmeprotokolle. Einige Kliniken rüsten ihre Notfallstationen mit computergestützten Systemen aus, die Patientendaten in Echtzeit analysieren und auf Hochrisikofälle aufmerksam machen.

Diese technologische Revolution verbessert die Reaktionsfähigkeit der medizinischen Teams, reduziert Fehldiagnosen bei der Erstbeurteilung und optimiert therapeutische Entscheidungen, was eine bessere Sicherheit für Kinder garantiert.

In diesem Kontext werden ChatGPT und andere Künstliche Intelligenzen zu unverzichtbaren Partnern, die Familien von den ersten Anzeichen an beraten und die Notaufnahmen auf eine schnelle und angepasste Intervention vorbereiten können.

Dieses neue medizinische Paradigma, das auf der Zusammenarbeit von KI und Fachkräften basiert, stellt Sicherheit und Patientengesundheit in den Mittelpunkt der Innovationen.

{„@context“:“https://schema.org“,“@type“:“FAQPage“,“mainEntity“:[{„@type“:“Question“,“name“:“ChatGPT peut-il remplacer un mu00e9decin en cas du2019urgence ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Non, ChatGPT est un outil du2019aide u00e0 la du00e9cision et ne peut jamais se substituer u00e0 un diagnostic mu00e9dical par un professionnel.“}},{„@type“:“Question“,“name“:“Comment garantir la su00e9curitu00e9 des donnu00e9es lors de lu2019utilisation de ChatGPT ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Il est important de ne pas divulguer du2019informations personnelles sensibles et de respecter les ru00e8gles de confidentialitu00e9 liu00e9es u00e0 la plateforme utilisu00e9e.“}},{„@type“:“Question“,“name“:“Quelles sont les u00e9tapes u00e0 suivre si ChatGPT recommande une urgence ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Les parents doivent immu00e9diatement se rendre aux urgences et informer les mu00e9decins que cette recommandation provient du2019une intelligence artificielle.“}},{„@type“:“Question“,“name“:“Lu2019IA peut-elle du00e9tecter toutes les maladies rares ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Non, bien que lu2019IA ait une large base de donnu00e9es, certaines maladies rares peuvent u00e9chapper u00e0 son analyse. Elle reste un complu00e9ment et non un substitut.“}},{„@type“:“Question“,“name“:“Quels sont les risques de lu2019auto-mu00e9dication basu00e9e sur lu2019IA ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Lu2019auto-mu00e9dication sans avis mu00e9dical peut mener u00e0 des erreurs graves, il est crucial de consulter un spu00e9cialiste pour tout traitement.“}}]}Kann ChatGPT einen Arzt im Notfall ersetzen?

Nein, ChatGPT ist ein Entscheidungshilfswerkzeug und kann niemals eine medizinische Diagnose durch einen Fachmann ersetzen.

Wie wird die Datensicherheit bei der Nutzung von ChatGPT gewährleistet?

Es ist wichtig, keine sensiblen persönlichen Informationen preiszugeben und die Datenschutzbestimmungen der genutzten Plattform zu beachten.

Welche Schritte sind zu befolgen, wenn ChatGPT einen Notfall empfiehlt?

Die Eltern müssen sofort in die Notaufnahme gehen und die Ärzte darüber informieren, dass diese Empfehlung von einer Künstlichen Intelligenz stammt.

Kann die KI alle seltenen Krankheiten erkennen?

Nein, obwohl die KI über eine umfangreiche Datenbasis verfügt, können einige seltene Krankheiten ihrer Analyse entgehen. Sie ist ein Ergänzung und kein Ersatz.

Welche Risiken birgt die Selbstmedikation auf Basis der KI?

Selbstmedikation ohne ärztliche Beratung kann zu schweren Fehlern führen, es ist wichtig, für jede Behandlung einen Spezialisten zu konsultieren.