Im Zeitalter der künstlichen Intelligenz war die visuelle Wahrnehmung von Maschinen noch nie so weit fortgeschritten. Meta, ein Gigant der digitalen Technologien, hat mit seinen Modellen SAM3 und SAM3D einen wichtigen Meilenstein erreicht, der die Bilderkennung und Computer Vision neu definiert. Diese neuen Systeme integrieren fortgeschrittene Techniken des Deep Learning und der Bildverarbeitung und verschieben die Grenzen des Möglichen in der visuellen Analyse. Mehr als nur eine einfache Objeksegmentierung ist es die Fähigkeit, die Elemente einer Szene zu verstehen, zu isolieren und sogar dreidimensional zu rekonstruieren, die neue Horizonte eröffnet.

Im Jahr 2025 positionieren sich diese Technologien als revolutionäre Werkzeuge, die in der Lage sind, die digitale und physische Welt zu transformieren. Ihre überlegenen Leistungen bei der Identifikation von Objekten anhand einer einfachen textuellen Beschreibung, ihre Fähigkeit, die visuelle Kontinuität in komplexen Videosequenzen aufrechtzuerhalten, und ihre Fähigkeit zur 3D-Rekonstruktion aus Bildern machen SAM3 und SAM3D zu bedeutenden Innovationen. Diese auf einer Basis von mehr als 11 Millionen Bildern trainierten Modelle illustrieren das spektakuläre Potenzial der Verschmelzung von künstlicher Intelligenz und Computer Vision perfekt.

Dieser technologische Wandel wird nicht nur Forscher und Entwickler betreffen, sondern auch die kreativen, kommerziellen und wissenschaftlichen Industrien. Während die Bildverarbeitung intuitiver, effizienter und präziser wird, verspricht der Aufschwung fortschrittlicher KI-Modelle wie SAM3 und SAM3D eine Neuerfindung von Bereichen, die so unterschiedlich sind wie Überwachung, Online-Handel, Robotik oder auch der Erhalt der Biodiversität. Entdecken Sie einen detaillierten Überblick über diese Innovationen und ihre praktischen Auswirkungen in der Bilderkennung.

- 1 Wie Meta SAM3 die Bilderkennung durch intelligente Segmentierung revolutioniert

- 2 SAM3D: Die dreidimensionale Visionstechnologie, die ein einfaches Foto zu einem 3D-Objekt macht

- 3 Detaillierte Hauptfunktionen von Meta SAM3 und SAM3D für fortgeschrittene Computer Vision

- 4 Die von einer gigantischen Datenmaschine unterstützte Entwicklung und die Auswirkungen auf die Präzision

- 5 Konkrete Anwendungen von Meta SAM3 / SAM3D in Industrie, Wissenschaft und Freizeit

- 6 Die aktuellen Beschränkungen und Grenzen von Meta SAM3 / SAM3D

- 7 Vergleich zwischen Meta SAM3 / SAM3D und anderen KI-Technologien zur Bilderkennung

- 8 Zugang, Kosten und Nutzungsmodelle von Meta SAM3 / SAM3D im aktuellen Technologielandschaft

Wie Meta SAM3 die Bilderkennung durch intelligente Segmentierung revolutioniert

Das Modell Meta SAM3 stellt einen echten Fortschritt im Bereich der Bilderkennung durch künstliche Intelligenz dar. Im Gegensatz zu früheren Generationen begnügt sich dieses System nicht damit, isolierte Pixel zu analysieren: Es segmentiert mit außergewöhnlicher Präzision jedes Objekt in einem Bild oder Video. Diese Segmentierung erfolgt anhand eines einfachen Klicks oder sogar einer vom Nutzer gegebenen textuellen Beschreibung, was die Interaktion zwischen Mensch und Maschine radikal vereinfacht.

Eine der Stärken von SAM3 liegt in seiner Fähigkeit, ohne vorheriges spezifisches Training zu funktionieren. Mit anderen Worten, das Modell kann sofort ein Objekt isolieren, das es noch nie zuvor gesehen hat, unabhängig von dessen Form oder Eigenschaften. Zum Beispiel muss ein Amateurfotograf, der alle roten Fahrräder in einer urbanen Szene extrahieren möchte, nur die Beschreibung „alle roten Fahrräder“ schreiben. SAM3 identifiziert und zeichnet die Konturen der entsprechenden Objekte ohne mühsame Intervention oder spezielle Datenvorbereitung nach. Diese Funktion, genannt Promptable Concept Segmentation (PCS), verbindet das Verständnis natürlicher Sprache mit der visuellen Macht des Deep Learning, eine Kombination, die durch die von Meta entwickelte ausgeklügelte Architektur möglich gemacht wird.

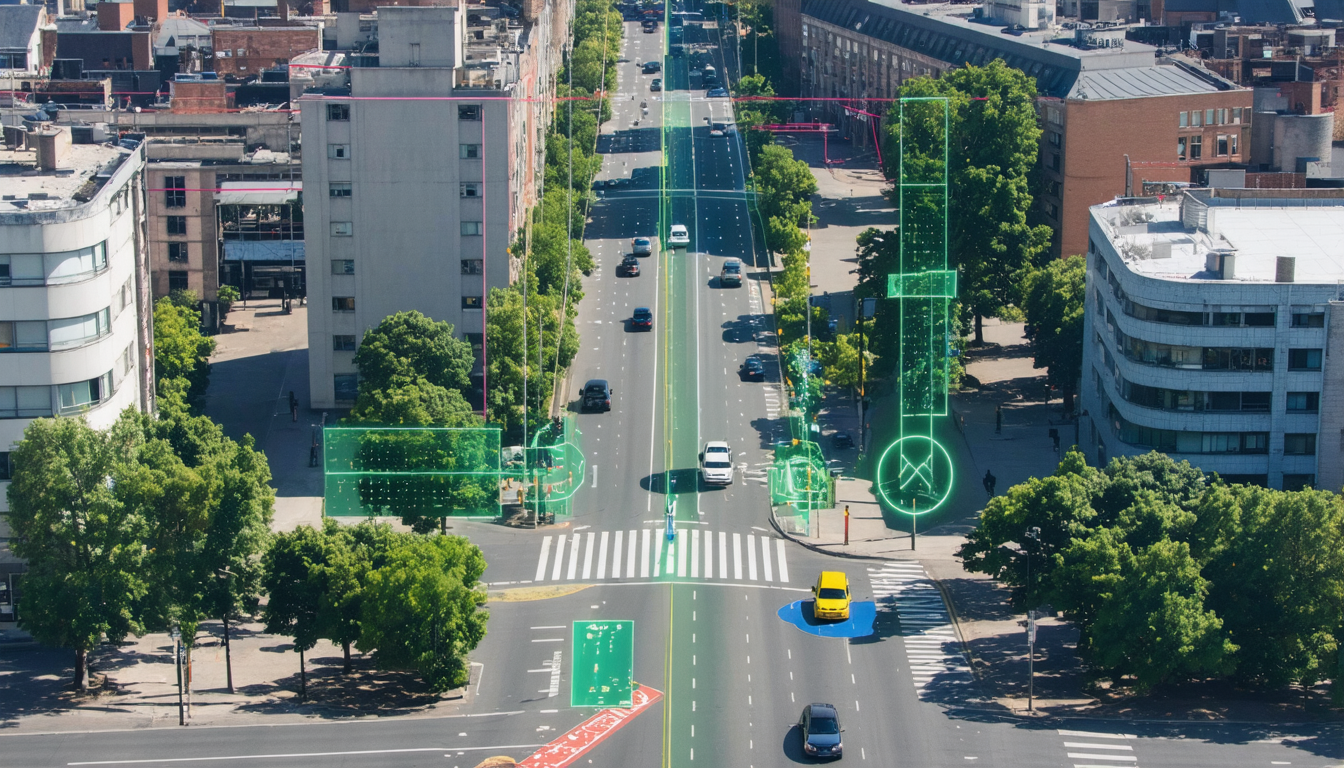

Die intelligente Segmentierung beschränkt sich nicht auf Standbilder: Auch Videostreams profitieren von dieser fortgeschrittenen Bildverarbeitung. SAM3 verwendet sogenannte „masklets“, um Objekte präzise zu verfolgen, selbst wenn sie teilweise verdeckt sind oder sich in dynamischen Szenen bewegen. Zum Beispiel behält das Modell in einem Überwachungsvideo die Verfolgung einer Person bei, selbst wenn diese sich hinter einem Hindernis bewegt. Diese Fähigkeit garantiert eine zuverlässige zeitliche Nachverfolgung und eröffnet Anwendungen wie automatisierte Videoüberwachung oder kreative Werkzeuge für sofortigen Videoschnitt.

Die einheitliche Architektur von SAM3 zeichnet sich auch durch ihre einzigartige Rückenstruktur aus, die Bilder und Videos einheitlich verarbeitet. Diese interne Organisation reduziert den Ressourcenverbrauch und erhöht die Verarbeitungsgeschwindigkeit, was optimale Leistung auch in anspruchsvollen Kontexten bietet. Dank dieser Ingenieurskunst verwandelt SAM3 die Bilderkennung in ein flüssiges und zugängliches Erlebnis, das emblematisch für die Fortschritte der künstlichen Intelligenz ist, die 2025 die Computer Vision tiefgreifend prägen.

SAM3D: Die dreidimensionale Visionstechnologie, die ein einfaches Foto zu einem 3D-Objekt macht

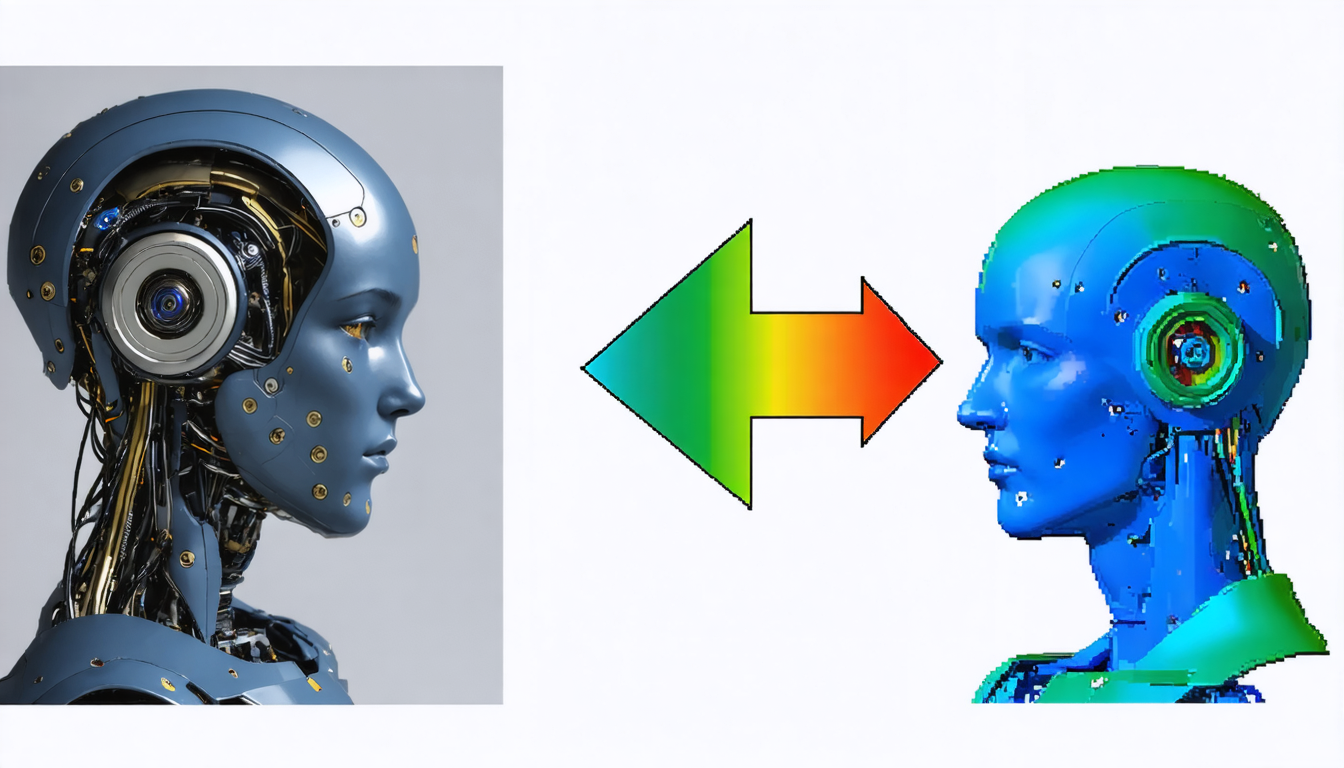

Über die klassische Segmentierung hinaus innoviert Meta mit SAM3D, einem Modell, das die Bilderkennung auf räumliche 3D-Ebenen hebt. Mithilfe von Referenzdaten aus der Multikamera-Computer Vision und LiDAR-Scans gelingt es SAM3D, Objekte aus gewöhnlichen Bildern in 3D zu rekonstruieren und eröffnet dabei eine neue Ära der automatischen visuellen Interpretation.

Diese Technologie stützt sich auf zwei spezialisierte Module. SAM 3D Objects richtet sich an unbelebte Alltagsobjekte. Aus einem einfachen Foto generiert es ein texturiertes, dreidimensional manipulierbares Mesh, das Teilokklusionen bewältigt. Wenn also ein Objekt teilweise hinter einem anderen verborgen ist, kann SAM3D die fehlende Form mithilfe intensiver logischer und kontextueller Schlussfolgerungen vorhersagen. Zum Beispiel wird in einem Bild, in dem eine Tasse einen Teil einer Vase verdeckt, das Gefäß vollständig rekonstruiert – eine Leistung, die die Fähigkeiten traditioneller Modelle deutlich übersteigt.

Für lebende Wesen, insbesondere Menschen, entfaltet SAM 3D Body ein bisher unbekanntes Körperdarstellungsmodell. Es unterscheidet zwischen Skelett, Fleisch und sogar Kleidung und ermöglicht eine feine Analyse von Posen und komplexen Bewegungen. Diese Innovation verleiht digitalen Avataren eine bisher nie dagewesene Flüssigkeit und Natürlichkeit und ebnet den Weg für Anwendungen in virtueller Realität, Animation oder Ergonomie.

SAM3D stellt somit einen bedeutenden Fortschritt in der Bildverarbeitung dar, da es nicht nur die Wahrnehmung, sondern auch die Modellierung von Objekten verändert. Dieses Eintauchen in die dritte Dimension wirft die Frage auf, ob sich Bildern ein echter physischer „Sinn“ verleihen lässt, der als Grundlage für natürlichere Interaktionen zwischen Mensch und Maschine dient.

Detaillierte Hauptfunktionen von Meta SAM3 und SAM3D für fortgeschrittene Computer Vision

Meta SAM3 und SAM3D beschränken sich nicht nur auf Segmentierung und Rekonstruktion von Objekten: Diese Modelle führen eine Reihe innovativer Funktionen ein, die den Standardansatz des Deep Learning in der Bilderkennung revolutionieren.

Das Flaggschiff-Feature, Promptable Concept Segmentation (PCS), ermöglicht die sehr präzise Segmentierung von Konzepten, die in natürlicher Sprache ausgedrückt werden. Diese Fähigkeit vereint sprachliches Verständnis und visuelle Interpretation in Echtzeit. Diese Kombination bietet einen doppelten Vorteil: Einerseits entfällt die Notwendigkeit teurer manueller Annotationen, andererseits steigt die Zugänglichkeit der KI-Tools für ein breites Publikum, sei es Experte oder Laie.

Zu den weiteren bemerkenswerten Funktionen gehören:

- Intelligente zeitliche Verfolgung in Videos, die masklets verwendet, um die Identität von Objekten selbst bei Okklusion aufrechtzuerhalten

- Handhabung von teilweisen 3D-Okklusionen, die eine kohärente Rekonstruktion verborgener Objekte ermöglichen

- Zero-Shot-Generalisation, die die Erkennung von Objekten ermöglicht, die während des Trainings nie gesehen wurden

- Ein Validierungsmechanismus mittels Presence Token, der Interpretationsfehler vermeidet und visuelle Halluzinationen begrenzt

- Eine einheitliche Architektur, optimiert für schnelle Verarbeitung von Standbildern und Videostreams

Diese fortschrittlichen Technologien haben die direkte Auswirkung, die Möglichkeiten realer Anwendungen in zahlreichen Bereichen deutlich zu vervielfachen und die Erstellung, Automatisierung sowie präzise Analyse komplexer visueller Elemente zu erleichtern.

Die von einer gigantischen Datenmaschine unterstützte Entwicklung und die Auswirkungen auf die Präzision

Die Stärke von Meta SAM3 / SAM3D beruht auch auf der immensen Datenbasis, auf der die Modelle trainiert wurden. Mehr als 11 Millionen annotierte Bilder dienten dazu, der KI ein feines und diversifiziertes Verständnis der visuellen Welt zu verleihen.

Diese umfangreiche Basis wird durch den SA-Co-Benchmark ergänzt, eine wissenschaftliche Sammlung mit fast vier Millionen verschiedenen annotierten Konzepten. Diese Fülle ermöglicht es der KI, feine Nuancen zwischen ähnlichen Objekten zu erfassen, beispielsweise den Unterschied zwischen einem „Vorderrad“ und einem „Hinterrad“ eines Fahrzeugs. Ein Beispiel, das von der Raffinesse des Modells und seiner Fähigkeit zeugt, die visuelle Analyse im Kontext zu verfeinern.

Das Annotationsverfahren stützt sich auf eine innovative hybride Arbeits-Schleife: Die KI führt eine automatische Vorausannotation durch, die die menschliche Arbeit beschleunigt, woraufhin Experten in Echtzeit validieren und korrigieren. Dieser schnelle Prozess, etwa fünffach effizienter als traditionelle manuelle Annotation, ermöglichte die Schaffung einer kolossalen und höchst qualitativen Datenmaschine.

Dieser methodische Ansatz garantiert Meta SAM3 / SAM3D eine große Robustheit und Verlässlichkeit, minimiert Fehler und die früher bei Systemen auftretenden „Halluzinationen“. Das Ergebnis ist ein System, das zugleich leistungsstark und präzise ist und das Potenzial hat, die großflächige Bildverarbeitung nachhaltig zu transformieren.

Konkrete Anwendungen von Meta SAM3 / SAM3D in Industrie, Wissenschaft und Freizeit

Die fortgeschrittenen Fähigkeiten der Modelle SAM3 und SAM3D begeistern schnell vielfältige Sektoren und generieren zahlreiche innovative Anwendungen.

Im Online-Handel nutzt Facebook Marketplace bereits SAM3 über die Funktion „View in Room“. Diese Funktion ermöglicht Verkäufern, ein Produktfoto, etwa eines Stuhls, sofort in ein virtuelles 3D-Objekt zu verwandeln, sodass der Käufer es direkt via Augmented Reality in seinem Zuhause visualisieren kann. Ein immersives Erlebnis, das die Codes des Fernverkaufs durchbricht und die Konversionsrate deutlich verbessert.

Content Creator auf Instagram profitieren von intelligenter Schnittsoftware, die auf SAM3 basiert. Diese automatisiert komplexe Befehle wie „Hintergrund unscharf machen“ oder „Himmel in Schwarzweiß umwandeln“, ausgeführt in einem Bruchteil einer Sekunde. So wird visuelle Kreation intuitiver und zugänglicher, ohne umfangreiche technische Kenntnisse zu erfordern.

In den Naturwissenschaften nutzt Conservation X Labs SAM3 zur Analyse riesiger Mengen an Bildern und Videos, die mit Kamerafallen aufgenommen wurden. Das automatische Erkennen seltener oder bedrohter Arten erleichtert die ökologische Überwachung und den Schutz der Biodiversität erheblich.

Schließlich profitiert die Robotik von einer verbesserten Wahrnehmung durch SAM3D, die für die präzise Handhabung von Objekten in komplexen Umgebungen unerlässlich ist. Roboter können den optimalen Greifpunkt berechnen, sich mühelos durch überfüllte Räume bewegen und auf Sprachbefehle reagieren, um mit unbekannten Objekten zu interagieren – ein Fortschritt, der die moderne Robotik neu definiert.

Die aktuellen Beschränkungen und Grenzen von Meta SAM3 / SAM3D

Trotz seines rasanten Fortschritts in der Bilderkennung durch künstliche Intelligenz ist das Duo SAM3 / SAM3D nicht frei von technischen Herausforderungen und Beschränkungen.

Zum Beispiel ist die Qualität der erzeugten 3D-Texturen manchmal moderat. Feine Details wie Haare, feine Maschen oder manche transparente Objekte können am Ausgang des Modells unscharf oder vereinfacht erscheinen. Diese Einschränkung begrenzt die Nutzung dieser Objekte in Produktionen, die eine filmische Auflösung sehr hoher Qualität erfordern, wie etwa Filme oder AAA-Spiele.

Eine weitere große Herausforderung liegt im realen physischen Verständnis von Umgebungen. Das Modell „sieht“ Formen, versteht aber nicht die materiellen Eigenschaften wie Schwerkraft, Festigkeit oder Kollisionsverhalten. So kommt es vor, dass in 3D rekonstruierte Objekte sich durchdringen oder ineinanderfallen, ohne die physikalischen Gesetze zu respektieren – eine Grenze, die durch manuelle Nachbearbeitung ausgeglichen werden muss.

Schließlich bleiben visuelle Halluzinationen trotz der Presence Tokens in komplexen und stark überfüllten Szenen bestehen, in denen sich Objekte stark ähneln. Die Videoverfolgung kann manchmal aussetzen, was eine menschliche Kontrolle erfordert, um kritische Fehler zu vermeiden, insbesondere im Bereich Überwachung oder Medizin.

Der hohe Speicherverbrauch (VRAM) zur Ausführung dieser Modelle limitiert auch deren Einsatz auf mobilen Geräten. Derzeit sind leistungsfähige IT-Umgebungen und eine robuste Internetverbindung unverzichtbar, was die Entstehung autonomer eingebetteter Nutzungsmöglichkeiten hemmt.

Vergleich zwischen Meta SAM3 / SAM3D und anderen KI-Technologien zur Bilderkennung

In einem sich schnell entwickelnden Sektor gibt es viele Alternativen zu den Modellen von Meta, die manchmal spezialisiertere oder ergänzende Lösungen anbieten.

| Technologie | Besonderheit | Stärken | Beschränkungen |

|---|---|---|---|

| Meta SAM3 / SAM3D | Fortgeschrittene Segmentierung und 3D-Rekonstruktion | Vielseitigkeit, Zero-Shot, integrierte Video- und Bildverarbeitung | Hoher Verbrauch, begrenzte 3D-Texturen |

| Google DeepMind Gemini 3 | Integrale Multimodalität und logisches Denken | Exzellenz bei komplexer Dokumentenanalyse | Weniger leistungsfähig bei reiner 3D-Geometrie |

| OpenAI Sora 2 | Generierung und Verständnis dynamischer Videos | Erstellung realistischer physischer Szenen | Weniger geeignet für Segmentierung |

| YOLO | Schnelle Objekterkennung und -zählung | Extrem leicht und schnell | Weniger präzise, keine 3D-Rekonstruktion |

| MedSAM | Spezialisiert auf medizinische Bildgebung | Medizinische Zertifizierung, hohe Präzision | Nicht vielseitig, sehr zielgerichteter Einsatz |

Diese Vielfalt fördert das Entstehen eines reichen und auf alle Einsatzbereiche zugeschnittenen Angebots, bei dem die Generalisierung von Meta SAM3 / SAM3D durch spezialisierte Lösungen mit spezifischen Profilen ergänzt wird.

Zugang, Kosten und Nutzungsmodelle von Meta SAM3 / SAM3D im aktuellen Technologielandschaft

Meta hat für seine Modelle SAM3 und SAM3D eine ambitionierte Öffnungspolitik gewählt. Die Gewichte dieser Modelle sind kostenlos und für die Forschung zugänglich, insbesondere über populäre Plattformen wie Hugging Face. Diese Strategie verfolgt das Ziel, einen offenen technologischen Standard im Bereich der Bilderkennung und der Bildverarbeitung durch KI durchzusetzen.

Die Echtzeitausführung erfordert jedoch eine leistungsfähige Infrastruktur, vor allem, um eine Verarbeitung in weniger als 30 Millisekunden pro Bild zu erzielen. Die Verfügbarkeit leistungsstarker Grafikprozessoren wie dem H200 ist essentiell und beschränkt die Nutzung auf Fachleute und spezialisierte Rechenzentren.

Für Endnutzer erfolgt der Zugang meist über die Cloud und Webschnittstellen wie das Segment Anything Playground, das diese Werkzeuge kostenlos erproben lässt. Allerdings erfordert die vollständige Integration dieser Modelle in kommerzielle Produkte oft spezielle und kostspielige Lizenzen namens „SAM License“, die die Nutzung regulieren und das geistige Eigentum von Meta schützen.

Zusammenfassend ist die Technologie für die Forschung weitgehend demokratisiert, ihre Industrialisierung erfordert jedoch erhebliche Investitionen in Hardware und rechtliche Verträge. Diese Dualität zwischen kostenlosem Code und Nutzungskosten ist eine häufige Realität im Bereich richtungsweisender Spitzentechnologien.

{„@context“:“https://schema.org“,“@type“:“FAQPage“,“mainEntity“:[{„@type“:“Question“,“name“:“Quu2019est-ce que le modu00e8le Meta SAM3 ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Meta SAM3 est un modu00e8le du2019intelligence artificielle capable de segmenter automatiquement et rapidement nu2019importe quel objet pru00e9sent dans une image ou une vidu00e9o u00e0 partir du2019une simple description textuelle ou du2019un clic.“}},{„@type“:“Question“,“name“:“Comment SAM3D transforme-t-il les images en objets 3D ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“SAM3D utilise des donnu00e9es issues de la vision multi-camu00e9ras et des scans LiDAR pour reconstruire des objets en trois dimensions u00e0 partir du2019une seule photo, en gu00e9nu00e9rant des maillages texturu00e9s manipulables.“}},{„@type“:“Question“,“name“:“Quels sont les avantages de la segmentation conceptuelle (PCS) ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“La segmentation conceptuelle permet u00e0 lu2019utilisateur de demander au modu00e8le du2019isoler pru00e9cisu00e9ment des objets selon des descriptions en langage naturel, sans nu00e9cessiter du2019entrau00eenement spu00e9cifique, rendant les outils accessibles et puissants.“}},{„@type“:“Question“,“name“:“Quels secteurs bu00e9nu00e9ficient le plus de Meta SAM3 / SAM3D ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Les secteurs comme le commerce en ligne, la cru00e9ation de contenu, la robotique, la surveillance vidu00e9o et la conservation de la biodiversitu00e9 exploitent activement ces technologies pour amu00e9liorer leurs processus.“}},{„@type“:“Question“,“name“:“Est-ce que SAM3 / SAM3D sont accessibles gratuitement ?“,“acceptedAnswer“:{„@type“:“Answer“,“text“:“Les modu00e8les sont accessibles gratuitement pour la recherche via des plateformes ouvertes, mais lu2019utilisation commerciale demande souvent des licences spu00e9cifiques et une infrastructure de calcul cou00fbteuse.“}}]}Was ist das Modell Meta SAM3?

Meta SAM3 ist ein künstliches Intelligenzmodell, das in der Lage ist, automatisch und schnell jedes beliebige Objekt, das in einem Bild oder Video vorhanden ist, anhand einer einfachen textuellen Beschreibung oder eines Klicks zu segmentieren.

Wie verwandelt SAM3D Bilder in 3D-Objekte?

SAM3D nutzt Daten aus der Multi-Kamera-Computer Vision und LiDAR-Scans, um Objekte aus einem einzigen Foto in drei Dimensionen zu rekonstruieren und texturierte, manipulierbare Meshes zu erzeugen.

Was sind die Vorteile der Konzeptsegmentierung (PCS)?

Die Konzeptsegmentierung ermöglicht es dem Benutzer, vom Modell zu verlangen, Objekte präzise nach Beschreibungen in natürlicher Sprache zu isolieren, ohne spezielles Training zu benötigen, was die Werkzeuge zugänglich und leistungsfähig macht.

Welche Sektoren profitieren am meisten von Meta SAM3 / SAM3D?

Sektoren wie Online-Handel, Content-Erstellung, Robotik, Videoüberwachung und Naturschutz nutzen diese Technologien aktiv, um ihre Prozesse zu verbessern.

Sind SAM3 / SAM3D kostenlos zugänglich?

Die Modelle sind für Forschungszwecke über offene Plattformen kostenlos zugänglich, aber für die kommerzielle Nutzung sind oft spezielle Lizenzen und eine kostspielige Recheninfrastruktur erforderlich.