Im aktuellen Kontext, der von einer schnellen und weitverbreiteten Einführung künstlicher Intelligenz in französischen Unternehmen geprägt ist, sind die Vorteile unbestreitbar: Produktivitätssteigerung, beschleunigte digitale Transformation und Automatisierung zahlreicher Aufgaben. Dennoch geht diese Entwicklung mit erheblichen Risiken einher, die manchmal unbekannt oder unterschätzt werden und die Sicherheit, Vertraulichkeit und sogar die Nachhaltigkeit der Organisationen gefährden können. Die Generaldirektion für innere Sicherheit (DGSI) hat kürzlich einen Eingriffs-Flash veröffentlicht, der diese Schwachstellen anhand von drei realen Fällen aus französischen Unternehmen beleuchtet und die Gefahren aufzeigt, die drohen, wenn die eingesetzten KI-Werkzeuge nicht vollständig beherrscht werden.

Diese Beispiele zeigen verschiedene Facetten der technologischen und organisatorischen Herausforderungen auf: Einerseits die Manipulation sensibler Daten durch unkontrollierte externe Werkzeuge, andererseits das übermäßige Vertrauen in autonome Entscheidungssysteme und schließlich das zunehmende Risiko hochentwickelter Angriffe mithilfe von Deepfake-Technologien. Dieser Artikel taucht in diese drei konkreten Beispiele ein, um die wesentlichen Herausforderungen zu vertiefen, denen französische Unternehmen bei der Erforschung und Nutzung künstlicher Intelligenz begegnen, indem er ethische Risiken, algorithmische Verzerrungen, Datenschutzprobleme und Anforderungen der IT-Sicherheit behandelt. Dabei soll auch bewertet werden, wie eine angemessene KI-Regulierung in Kombination mit einer strengen Governance kostspielige Fehler verhindern und die Integrität der nationalen Wirtschaftsstrukturen bewahren kann.

- 1 Unangemessene Nutzung generativer KI: ein alarmierendes Beispiel für französische Unternehmen

- 2 Gefahren der Abhängigkeit von KI für strategische Entscheidungen in französischen Unternehmen

- 3 Hochentwickelte Deepfake-Betrügereien, eine wachsende Bedrohung für französische Unternehmen

- 4 Wesentliche Empfehlungen zur Regulierung der Nutzung künstlicher Intelligenz in französischen Unternehmen

- 5 Statistiken und wirtschaftliche Auswirkungen künstlicher Intelligenz in französischen Unternehmen

- 6 Ethische Risiken und algorithmische Verzerrungen: Herausforderungen für französische Unternehmen im Umgang mit künstlicher Intelligenz

- 7 Digitale Transformation und Datenschutzherausforderungen in französischen Unternehmen

- 8 Strategischer Ansatz für eine erfolgreiche Integration von KI in französische Unternehmen

Unangemessene Nutzung generativer KI: ein alarmierendes Beispiel für französische Unternehmen

Der erste von der DGSI hervorgehobene Fall betrifft ein strategisches Unternehmen, das ein öffentliches, im Ausland entwickeltes generatives KI-Werkzeug zur Übersetzung sensibler interner Dokumente einsetzt. Die Nutzung dieses Werkzeugs war spontan von einigen Mitarbeitern übernommen worden, die von der Effizienz und Geschwindigkeit begeistert waren, die es bei der täglichen Verwaltung von Inhalten bot. Diese Praxis, die ohne hierarchische Genehmigung oder vorherige Kontrolle begann, offenbarte schnell ihre Grenzen, als die IT-Leitung bei einem internen Audit eine potenzielle Datenpanne feststellte.

Der Einsatz kostenloser oder internationaler Dienste birgt ein besonderes Risiko, da eingegebene Daten häufig im Hintergrund zur Schulung der KI-Modelle verwendet werden können, oft ohne dass der Nutzer ausdrücklich darüber informiert wird. Dieses Phänomen stellt eine erhebliche Bedrohung für die Vertraulichkeit der Informationen dar, insbesondere wenn die Server dieser Unternehmen außerhalb des französischen oder sogar europäischen Hoheitsgebiets stehen und somit einer ausländischen Gesetzgebung unterliegen, die mitunter weniger strenge Regeln aufweist.

Angesichts dieser Erkenntnisse hat das Unternehmen die Nutzung dieses Dienstes eingestellt und setzt nun auf eine interne, kostenpflichtige Lösung, die eine sichere Umgebung gemäß den nationalen Standards bietet. Außerdem wurde eine spezielle Arbeitsgruppe eingesetzt, um eine strikte Nutzungspolitik für KI-Werkzeuge zu entwickeln. Dieser Ansatz unterstreicht den dringenden Bedarf für Unternehmen, die Nutzung fortschrittlicher Technologien zu strukturieren, um Sicherheitslücken zu vermeiden. Tatsächlich erhöhen die Risiken durch die Vernetzung mit externen Schnittstellen oder unkontrollierten Plugins die Angriffsfläche und die Anfälligkeit für Eindringlinge.

Im Rückblick auf dieses erste Beispiel wird deutlich, dass die Versuchung, einfache und kostenlose Werkzeuge zu nutzen, erhebliche Risiken verbergen kann. Für alle französischen Unternehmen, die sich der digitalen Transformation stellen, ist es unerlässlich, eine proaktive IT-Sicherheitspolitik zu verfolgen und den Datenschutz bereits in den frühen Phasen der Bewertung von KI-Werkzeugen zu integrieren.

Gefahren der Abhängigkeit von KI für strategische Entscheidungen in französischen Unternehmen

Der zweite Fall, der von den Nachrichtendiensten hervorgehoben wird, beschreibt ein Szenario, in dem ein französisches Unternehmen mit internationaler Expansion einen kritischen Teil seines Entscheidungsprozesses, die Due Diligence, an ein im Ausland entwickeltes KI-System ausgelagert hat. Ziel war es, Geschwindigkeit und Effizienz bei der Bewertung potenzieller Geschäftspartner auf unbekannten Märkten zu gewinnen.

Kurzfristig erwies sich diese Automatisierung als verlockend, da sie detaillierte und sofortige Berichte erzeugte. Aufgrund des Arbeitsvolumens und des Mangels an spezialisierten Humanressourcen, um die Ergebnisse zu überprüfen, neigten die Teams jedoch dazu, die gelieferten Resultate blind zu akzeptieren, ohne eine zusätzliche Expertenvalidierung vorzunehmen. Diese algorithmischen Systeme liefern jedoch probabilistische Antworten, die der statistisch wahrscheinlichsten Antwort entsprechen und nicht notwendigerweise frei von Verzerrungen oder perfekt auf den Kontext abgestimmt sind.

Algorithmische Verzerrungen, die bereits bei der Modellgestaltung oder durch Trainingsdaten eingeführt werden, können die Ergebnisse fehlerhaft lenken. Darüber hinaus gefährden die berüchtigten „Halluzinationen“ – die fehlerhafte, ungenaue oder erfundene Informationen generieren – die Zuverlässigkeit dieser Werkzeuge. Dieses Phänomen erhöht das Risiko, dass strategische Entscheidungen auf verzerrten Analysen basieren, was zu kommerziellen Verlusten, vertraglichen Konflikten oder Vertrauensbrüchen führen kann.

Das Beispiel zeigt daher, wie wichtig es ist, eine fachkundige menschliche Kontrolle in die Entscheidungsprozesse einzubinden, etwa durch die Benennung von KI-Ansprechpartnern, die die von diesen Systemen erzeugten Empfehlungen umformulieren, überprüfen und gewichten. Menschliche Wachsamkeit bleibt ein unverzichtbarer Schutz gegen die Reduzierung von Denkvielfalt und automatisierte Entscheidungen, die vom realen Kontext französischer Unternehmen entkoppelt sind.

Dieser Fall verdeutlicht auch eine weitere technologische Herausforderung: Wie lässt sich die durch Automatisierung und digitale Transformation gewonnene Optimierung mit der Aufrechterhaltung einer strengen strategischen Kontrolle verbinden? Schulungsprogramme und Sensibilisierung für die mit der Nutzung künstlicher Intelligenz verbundenen Risiken werden entscheidend sein, um die Agilität und Resilienz der Unternehmen auf einem wettbewerbsintensiven internationalen Markt zu bewahren.

Hochentwickelte Deepfake-Betrügereien, eine wachsende Bedrohung für französische Unternehmen

Der dritte von der DGSI angeführte Fall enthüllt einen besonders ausgeklügelten Betrugsversuch unter Einsatz von Deepfake-Technologien. Ein Verantwortlicher einer Industrieanlage erhielt einen Videoanruf von einer Person, die das Aussehen und die Stimme des Konzernleiters perfekt nachahmte und eine Finanzüberweisung im Rahmen eines Akquisitionsprojekts anforderte. Diese Täuschung wurde nur durch die Wachsamkeit und Intuition des Verantwortlichen erkannt, der die Kommunikation schnell unterbrach und die Geschäftsleitung alarmierte.

Audio- und Videomanipulationstechnologien sind inzwischen äußerst überzeugend geworden. Zwischen 2023 und 2025 hat sich das Volumen Deepfake-Inhalte im Netz mehr als verzehnfacht, und täglich zirkulieren mehrere Millionen dieser Videos, Bilder oder Aufnahmen. Diese Entwicklung wurde auch durch die Popularisierung generativer KI-Werkzeuge und Techniken der Sprachsynthese spektakulär beschleunigt.

Diese Angriffe basieren häufig auf einer sorgfältigen Sammlung und Analyse öffentlicher und privater Unternehmensdaten, um betrügerische Nachrichten zu personalisieren und somit ihre Glaubwürdigkeit und Manipulationskraft zu erhöhen. Fast die Hälfte der Unternehmen gibt an, bereits Ziel solcher Versuche gewesen zu sein, was das Ausmaß des Problems in Frankreich verdeutlicht. Die Industriebranche ist aufgrund ihrer wirtschaftlichen Bedeutung besonders gefährdet.

Es erscheint daher unerlässlich für französische Unternehmen, geeignete IT-Sicherheitsmaßnahmen einzuführen: Schulung der Mitarbeiter im Erkennen von Deepfakes, Einführung strenger Verifikationsprotokolle bei Finanzanfragen und Einsatz technologischer Lösungen zur Erkennung gefälschter Inhalte. Diese Maßnahmen müssen unbedingt die digitale Transformation begleiten, um zu verhindern, dass diese Innovationen zu Hebeln von Betrug und Desinformation werden.

Wesentliche Empfehlungen zur Regulierung der Nutzung künstlicher Intelligenz in französischen Unternehmen

Die Rückmeldungen der DGSI betonen die Notwendigkeit einer strengen Regulierung, um erkannte Gefahren zu vermeiden und gleichzeitig die Einführung künstlicher Intelligenz und ihrer zahlreichen Vorteile zu fördern. Ein erstes Gebot ist die klare Definition einer internen Richtlinie, die die Nutzung und die Arten von Daten, die über KI-Werkzeuge verarbeitet werden können, regelt.

Französische Unternehmen werden ermutigt, lokale oder europäische Lösungen zu bevorzugen, um Risiken in Bezug auf Datensouveränität und rechtlichen Schutz zu minimieren. Darüber hinaus erscheint die kontinuierliche Schulung der Mitarbeiter als ein weiteres fundamentales Element, das ihnen ermöglicht, die Herausforderungen zu verstehen, Risiken zu erkennen und die Einhaltung der Regeln zu gewährleisten.

Die DGSI empfiehlt zudem, interne Transparenzmaßnahmen einzurichten, insbesondere über einen Meldekanal für verdächtige Vorfälle, und eine regelmäßige Überprüfung der Praktiken im Zusammenhang mit künstlicher Intelligenz einzuführen. Die Integration spezialisierten menschlichen Validierungen muss systematisch erfolgen, insbesondere bei strategischen oder sensiblen Entscheidungen.

Schließlich ist die Zusammenarbeit zwischen öffentlichen und privaten Akteuren, einschließlich der KI-Regulierungsbehörden, entscheidend, um einen klaren und flexiblen Rahmen zu definieren, der die technologischen Veränderungen begleitet, ohne ethische Werte und die Sicherheit französischer Unternehmen zu gefährden.

- Eine klare interne Politik zur Nutzung von KI definieren

- Lokale oder europäische Lösungen bevorzugen

- Mitarbeiter regelmäßig schulen

- Ein Meldesystem für Vorfälle einrichten

- Für kritische Entscheidungen eine systematische menschliche Validierung gewährleisten

- Transparenz sicherstellen und Praktiken regelmäßig überprüfen

- Mit Behörden für einen angemessenen Regulierungsrahmen zusammenarbeiten

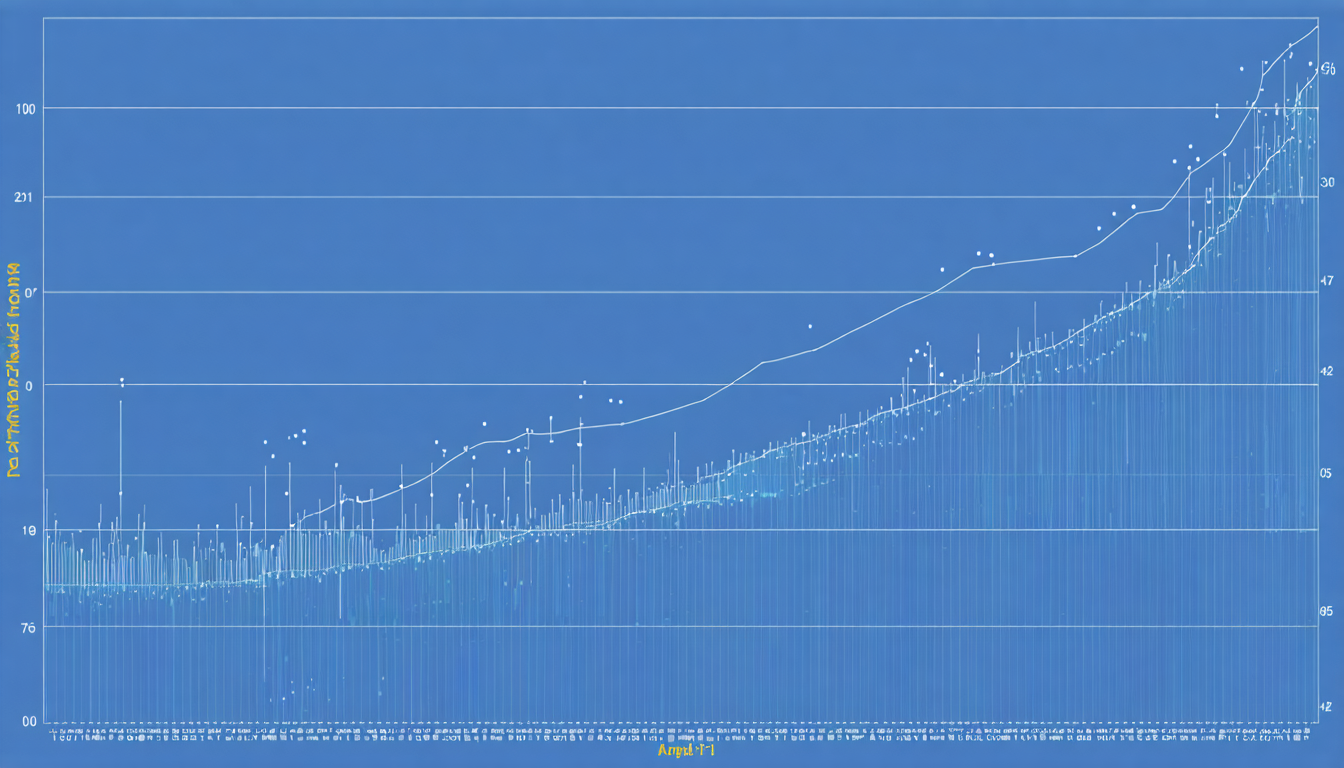

Statistiken und wirtschaftliche Auswirkungen künstlicher Intelligenz in französischen Unternehmen

Die Zahlen zeigen ein gemischtes Bild zwischen wirtschaftlichen Vorteilen und potenziellen Schwachstellen. Nahezu 78 % der globalen Unternehmen integrieren bereits künstliche Intelligenz in mindestens eine ihrer Funktionen. In Frankreich wächst dieser Trend kontinuierlich, nicht zuletzt dank der digitalen Transformation, die in vielen Sektoren vorangetrieben wird.

Laut mehreren Studien können die durch KI bedingten Produktivitätsgewinne Spitzenwerte von bis zu 55 % erreichen. Die durchschnittliche finanzielle Rentabilität wird auf etwa 3,70 Dollar pro investiertem Dollar geschätzt. Diese ökonomischen Aussichten reizen Entscheidungsträger, doch sie verbergen mitunter die inhärenten Risiken, insbesondere in den Bereichen IT-Sicherheit und Datenschutz.

Die folgende Tabelle fasst einige Schlüsselinformationen zusammen:

| Indikator | Wert | Kommentare |

|---|---|---|

| KI-Einführungsrate in Unternehmen (Frankreich) | 70% | Starker Anstieg seit 2023 |

| Produktivitätsgewinne durch KI | Bis zu 55% | Variabilität je nach Sektor und Nutzung |

| Durchschnittlicher finanzieller Ertrag | 3,70 $ pro investiertem Dollar | Signifikanter Vorteil gegenüber traditionellen Investitionen |

| Unternehmen ohne formelle KI-Politik | 1/3 | Mangelnde Governance erhöht Risiken |

| Unternehmen, die von Deepfakes betroffen sind | 46% | Schnelle Verbreitung dieser Bedrohung |

Ethische Risiken und algorithmische Verzerrungen: Herausforderungen für französische Unternehmen im Umgang mit künstlicher Intelligenz

Über Sicherheits- und Datenschutzfragen hinaus sehen sich französische Unternehmen einem grundlegenden Problem im Zusammenhang mit algorithmischen Verzerrungen gegenüber. Diese Verzerrungen treten auf, wenn die für das Training der Modelle verwendeten Daten nur teilweise repräsentativ sind oder wenn implizite Vorurteile in Programmen eingeschleust werden. Dies kann Diskriminierungen verursachen, Analyseergebnisse verfälschen oder automatisierte Entscheidungsprozesse beeinträchtigen.

Die ethischen Risiken durch solche Verzerrungen sind besonders wichtig für Unternehmen in sensiblen Bereichen wie Finanzen, Gesundheit oder Personalwesen. Zum Beispiel kann eine verzerrte KI unfaire Personalentscheidungen beeinflussen, bestimmte Kundengruppen benachteiligen oder fragwürdige Geschäftsentscheidungen begünstigen.

Um diesen Herausforderungen zu begegnen, müssen Unternehmen regelmäßige Audits der Algorithmen durchführen, ethische Konformitätstests durchführen und die Vielfalt der Entwicklungsteams stärken, um blinde Flecken zu minimieren. Die Sensibilisierung der Entscheidungsträger für diese Risiken und die Integration korrigierender Mechanismen sind ebenfalls unerlässlich.

Schließlich schreibt die europäische KI-Regulierung strenge Anforderungen an die Bewertung von Verzerrungen und Transparenz vor, was französische Unternehmen zwingt, diese Standards einzuhalten, um rechtliche Sanktionen und negative Auswirkungen auf ihr Image zu vermeiden.

Praktische Maßnahmen zur Reduzierung algorithmischer Verzerrungen

- Unabhängige Audits der verwendeten Modelle durchführen

- Fachübergreifende Experten in die Algorithmusentwicklung einbinden

- Repräsentative und vielfältige Datensätze verwenden

- Mechanismen zur Erklärbarkeit algorithmischer Entscheidungen implementieren

- Teams zu ethischen Risiken von KI schulen

Digitale Transformation und Datenschutzherausforderungen in französischen Unternehmen

Die durch die intensive Nutzung künstlicher Intelligenz beschleunigte digitale Transformation erfordert eine Verstärkung der Datenschutzrichtlinien. In diesem Zusammenhang müssen französische Unternehmen nicht nur die europäischen Datenschutz-Grundverordnung (DSGVO) einhalten, sondern auch spezifische Anforderungen im Hinblick auf die Vertraulichkeit und Integrität der von KI-Systemen verarbeiteten Daten antizipieren.

Die Manipulation sensibler Daten über automatisierte Schnittstellen kann das Risiko von Datenlecks und Missbrauch erhöhen. Daher muss eine verstärkte Cybersicherheitspolitik technische Werkzeuge mit strikter Governance verbinden, einschließlich der Festlegung klarer Rollen und der Verantwortlichmachung der Akteure.

Die Datensicherung umfasst auch die Kontrolle der externen Datenflüsse. Französische Unternehmen werden ermutigt, den Austausch mit nicht zertifizierten externen Plattformen oder solchen außerhalb der Europäischen Union zu begrenzen und souveräne Lösungen zu bevorzugen, die eine erhöhte Kontrolle über die Daten gewährleisten. Dieser Ansatz trägt dazu bei, das Vertrauen von Kunden und Partnern zu bewahren, was ein Schlüsselfaktor für die langfristige Stabilisierung von Geschäftsbeziehungen ist.

Strategischer Ansatz für eine erfolgreiche Integration von KI in französische Unternehmen

Schließlich müssen französische Unternehmen, um die Erfolgschancen der digitalen Transformation zu maximieren und Risiken zu minimieren, einen ganzheitlichen und integrierten strategischen Ansatz verfolgen. Dieser mobilisiert nicht nur KI-Technologien, sondern auch die Schulung der Teams, die Überarbeitung der Geschäftsprozesse sowie die Einführung einer Steuerung von Sicherheit und Compliance.

Eine angepasste KI-Governance umfasst die Ernennung verantwortlicher Personen, die Einrichtung von Ethik-Charts und die enge Zusammenarbeit mit den Regulierungsbehörden. Dieser Rahmen soll Innovation fördern und gleichzeitig eine verantwortungsvolle und transparente Nutzung gewährleisten.

Die Geschichte dieser drei Unternehmen illustriert, dass Innovation nicht ohne Wachsamkeit auskommt. Der Aufbau interner Kompetenzen, die Sensibilisierung für Risiken und Transparenz bezüglich erlaubter Praktiken sorgen für ein Gleichgewicht zwischen der Nutzung des Potenzials von KI und der Beherrschung der damit verbundenen Gefahren.