Dans le contexte actuel marqué par une adoption rapide et généralisée de l’intelligence artificielle dans les entreprises françaises, les bénéfices sont indéniables : amélioration de la productivité, transformation digitale accélérée, et automatisation de nombreuses tâches. Pourtant, ce développement s’accompagne de risques significatifs, parfois méconnus ou minimisés, qui peuvent fragiliser la sécurité, la confidentialité et même la pérennité des organisations. La Direction Générale de la Sécurité Intérieure (DGSI) a récemment publié un Flash ingérence mettant en lumière ces fragilités à travers trois cas réels vécus par des entreprises françaises, révélateurs des dangers qui guettent lorsqu’on ne maîtrise pas pleinement les outils d’intelligence artificielle employés.

Ces exemples exposent diverses facettes des défis technologiques et organisationnels : d’une part, la manipulation des données sensibles via des outils externes non maîtrisés, d’autre part, la confiance excessive accordée à des systèmes de décision autonomes, et enfin, la montée en puissance d’attaques sophistiquées utilisant des technologies deepfake. Cet article plonge dans ces trois illustrations concrètes pour approfondir les enjeux majeurs que rencontrent les entreprises françaises dans leur exploration et usage de l’intelligence artificielle, en traitant des risques éthiques, des biais algorithmiques, des problématiques de protection des données et des impératifs de sécurité informatique. Il s’agira également d’évaluer comment une réglementation IA appropriée, alliée à une gouvernance rigoureuse, peut prévenir des erreurs coûteuses et préserver l’intégrité des structures économiques nationales.

- 1 Utilisation inappropriée de l’IA générative : un exemple alarmant pour les entreprises françaises

- 2 Dangers de la dépendance à l’IA pour la prise de décision stratégique dans les entreprises françaises

- 3 Escroqueries sophistiquées par deepfake, une menace croissante pour les entreprises françaises

- 4 Les recommandations clés pour encadrer l’usage de l’intelligence artificielle dans les entreprises françaises

- 5 Statistiques et impacts économiques de l’intelligence artificielle dans les entreprises françaises

- 6 Risques éthiques et biais algorithmiques : défis pour les entreprises françaises face à l’intelligence artificielle

- 7 Transformation digitale et enjeux de protection des données dans les entreprises françaises

- 8 Approche stratégique pour une intégration réussie de l’IA dans les entreprises françaises

Utilisation inappropriée de l’IA générative : un exemple alarmant pour les entreprises françaises

Le premier cas mis en avant par la DGSI concerne une entreprise stratégique employant un outil d’intelligence artificielle générative public, développé à l’étranger, pour la traduction de documents internes sensibles. L’utilisation de cet outil avait été adoptée de manière spontanée par certains collaborateurs, séduits par l’efficacité et la rapidité qu’il offrait dans la gestion quotidienne des contenus. Cette pratique, initiée sans validation hiérarchique ni contrôle préalable, a rapidement révélé ses limites lorsque la direction informatique a détecté une fuite potentielle via un audit interne.

Le recours à des services gratuits ou internationaux présente un danger particulier, car les données saisies peuvent être utilisées pour entraîner les modèles d’intelligence artificielle en arrière-plan, souvent sans que l’utilisateur en soit informé explicitement. Ce phénomène pose une menace majeure sur la confidentialité des informations, d’autant plus lorsque les serveurs de ces sociétés sont situés hors du territoire français voire européen, exposant ces données à des législations étrangères aux règles parfois moins strictes.

Face à ce constat, l’entreprise a mis fin à l’utilisation de ce service au profit d’une solution interne et payante, proposant un environnement sécurisé conforme aux normes nationales. De plus, un groupe de travail spécifique a été mis en place pour élaborer une doctrine d’utilisation rigoureuse des outils d’IA. Cette démarche illustre le besoin crucial pour les entreprises de structurer l’usage des technologies avancées afin d’éviter les failles de sécurité. En effet, les menaces liées à l’interconnexion avec des interfaces externes ou des plugins non contrôlés augmentent le vecteur d’attaque et la vulnérabilité à des infiltrations.

En regardant l’ensemble de ce premier exemple, il devient clair que la tentation de recourir à des outils simples et gratuits peut cacher des risques considérables. Pour toutes les entreprises françaises qui s’engagent dans la transformation digitale, il est impératif d’adopter une politique de sécurité informatique proactive et d’intégrer la protection des données dans ses critères d’évaluation des outils IA dès les phases initiales.

Dangers de la dépendance à l’IA pour la prise de décision stratégique dans les entreprises françaises

Le deuxième cas souligné par les services de renseignement évoque un scénario où une société française en pleine expansion internationale a externalisé une partie critique de son processus de décision, la due diligence, à un système d’intelligence artificielle conçu à l’étranger. Cette démarche avait pour objectif de gagner en rapidité et en efficacité dans l’évaluation de partenaires commerciaux potentiels sur des marchés inconnus.

À court terme, cet automatisme s’est avéré séduisant car il générait des rapports détaillés et instantanés. Cependant, à cause du volume de travail et du manque de ressources humaines spécialisées pour vérifier les résultats, les équipes ont tendance à accepter aveuglément les résultats fournis sans recourir à une validation experte additionnelle. Or, ces systèmes algorithmiques fournissent des réponses probabilistes, qui correspondent à la réponse la plus statistiquement probable plutôt qu’à une réponse exempte de biais ou parfaitement adaptée au contexte.

Les biais algorithmiques, introduits dès la conception du modèle ou à travers les données d’entraînement, peuvent orienter incorrectement les résultats. Par ailleurs, les fameux « hallucinations » – générant des informations erronées, imprécises ou inventées – mettent en danger la fiabilité de ces outils. Ce phénomène accentue les risques de prise de décisions stratégiques basées sur des analyses biaisées, pouvant entraîner des pertes commerciales, des conflits contractuels ou une rupture de confiance.

L’exemple montre donc la nécessité cruciale d’intégrer un contrôle humain expert dans les boucles décisionnelles, par exemple en nommant des référents IA chargés de reformuler, vérifier et pondérer les recommandations générées par ces machines. La vigilance humaine reste un garde-fou indispensable contre la réduction de la diversité de pensée et les décisions automatisées déconnectées du contexte réel des entreprises françaises.

Ce cas illustre également un autre défi technologique de taille : comment conjuguer l’optimisation apportée par l’automatisation et la transformation digitale avec le maintien d’un contrôle stratégique rigoureux ? Les programmes de formation et la sensibilisation aux risques inhérents à l’utilisation de l’intelligence artificielle deviennent essentiels pour préserver l’agilité et la résilience des entreprises sur un marché international concurrentiel.

Escroqueries sophistiquées par deepfake, une menace croissante pour les entreprises françaises

Le troisième cas évoqué par la DGSI révèle une tentative d’escroquerie particulièrement sophistiquée impliquant l’usage de technologies deepfake. Un responsable d’un site industriel a reçu un appel vidéo d’un interlocuteur qui imitait parfaitement l’apparence et la voix du dirigeant du groupe, sollicitant un virement financier dans le cadre d’un projet d’acquisition. Cette supercherie n’a été décelée que grâce à la vigilance et à l’instinct du responsable, qui a rapidement interrompu la communication et alerté la direction.

Les technologies de manipulation audio et vidéo sont en effet devenues redoutablement convaincantes. Entre 2023 et 2025, le volume de contenus deepfake sur le net a été multiplié par plus de dix, et plusieurs millions de ces vidéos, images ou enregistrements circulent quotidiennement. Ce développement a vécu une accélération spectaculaire également en raison de la popularisation des outils d’IA générative et de techniques de synthèse de la parole.

Ces attaques se basent souvent sur une collecte et une analyse minutieuse des données publiques et privées d’une entreprise pour personnaliser les messages frauduleux, renforçant ainsi leur crédibilité et leur potentiel de manipulation. Près de la moitié des entreprises affirment avoir été ciblées par ce type de tentative, révélant l’ampleur du problème dans le paysage français. Le secteur industriel, par son fort enjeu économique, est particulièrement exposé.

Il apparait ainsi primordial pour les entreprises françaises de déployer des dispositifs de sécurité informatique adaptés : formation des collaborateurs à la reconnaissance des deepfakes, mise en place de protocoles de vérification stricte lors des sollicitations financières, et recours à des solutions technologiques capables de détecter les contenus falsifiés. Ces mesures doivent absolument accompagner la transformation digitale pour éviter que ces innovations ne deviennent des leviers de fraude et de désinformation.

Les recommandations clés pour encadrer l’usage de l’intelligence artificielle dans les entreprises françaises

Les retours de la DGSI insistent sur la nécessité d’un encadrement rigoureux pour éviter les dangers identifiés, tout en favorisant l’adoption de l’intelligence artificielle et ses nombreux bénéfices. Un premier impératif est la définition claire d’une politique interne dédiée, encadrant les usages et les types de données pouvant être traitées via des outils d’IA.

Les entreprises françaises sont encouragées à privilégier des solutions locales ou européennes afin de limiter les risques liés à la souveraineté des données et à la protection juridique. Par ailleurs, la formation continue des employés apparaît comme un autre pilier fondamental, leur permettant de comprendre les enjeux, d’identifier les risques, et d’adopter des comportements conformes aux règles.

La DGSI recommande aussi de mettre en place des dispositifs de transparence interne, notamment via un canal de signalement pour tout incident suspect, et d’instaurer une revue régulière des pratiques associées à l’intelligence artificielle. L’intégration de validations humaines spécialisées doit être systématique, en particulier pour les décisions stratégiques ou sensibles.

Enfin, la collaboration entre acteurs publics et privés, y compris les autorités de régulation IA, est essentielle pour définir un cadre clair et évolutif, susceptible d’accompagner les mutations technologiques sans compromettre les valeurs éthiques et la sécurité des entreprises françaises.

- Définir une politique interne claire sur l’usage de l’IA

- Préférer des solutions locales ou européennes

- Former régulièrement les collaborateurs

- Mettre en place un canal de signalement des incidents

- Garantir une validation humaine systématique pour les décisions critiques

- Assurer la transparence et la revue régulière des pratiques

- Collaborer avec les autorités pour un cadre réglementaire adapté

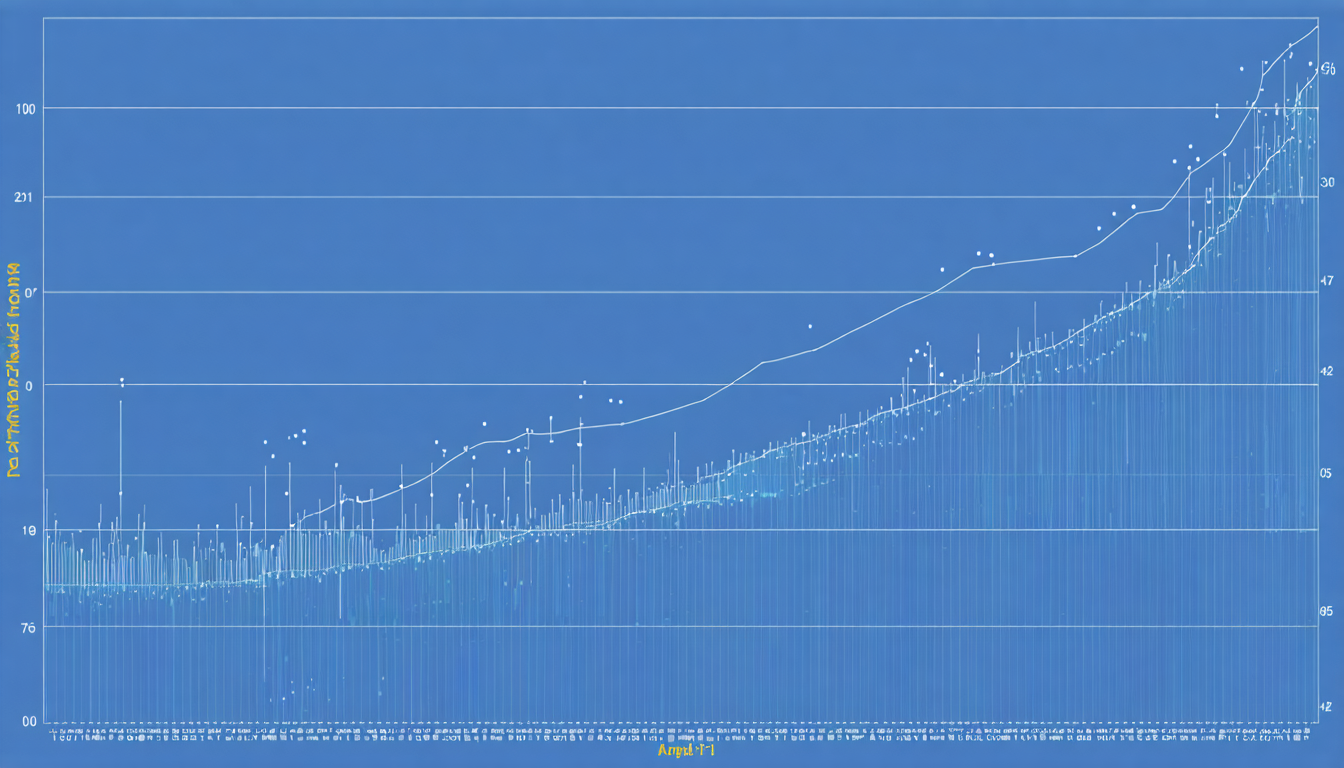

Statistiques et impacts économiques de l’intelligence artificielle dans les entreprises françaises

Les chiffres révèlent un panorama contrasté entre les bénéfices économiques et les vulnérabilités potentielles. Près de 78 % des entreprises mondiales intègrent déjà l’intelligence artificielle dans au moins une de leurs fonctions. En France, cette tendance est en constante progression, grâce notamment à la transformation digitale impulsée dans de nombreux secteurs.

Selon plusieurs études, les gains de productivité liés à l’IA peuvent atteindre des sommets allant jusqu’à 55 %. La rentabilité financière moyenne est estimée à environ 3,70 dollars générés par dollar investi. Ces perspectives économiques séduisent les dirigeants, mais elles masquent parfois les risques intrinsèques, notamment en matière de sécurité informatique et de respect de la vie privée.

Ce tableau synthétise certains indicateurs clés :

| Indicateur | Valeur | Commentaires |

|---|---|---|

| Taux d’adoption IA en entreprise (France) | 70% | En forte augmentation depuis 2023 |

| Gains de productivité liés à l’IA | Jusqu’à 55% | Variabilité selon secteur et usage |

| Retour financier moyen | 3,70 $ par dollar investi | Avantage significatif sur les investissements traditionnels |

| Entreprises sans politique IA formelle | 1/3 | Manque de gouvernance exposant aux risques |

| Entreprises visées par deepfakes | 46% | Propagation rapide de cette menace |

Risques éthiques et biais algorithmiques : défis pour les entreprises françaises face à l’intelligence artificielle

Au-delà des questions de sécurité et de protection des données, les entreprises françaises sont confrontées à un défi fondamental lié aux biais algorithmiques. Ces biais surviennent lorsque les données utilisées pour entraîner les modèles sont partiellement représentatives ou quand des préjugés implicites s’insèrent dans les programmes. Cela peut engendrer des discriminations, fausser les résultats d’analyse ou compromettre la prise de décision automatisée.

Les risques éthiques liés à ces biais sont cruciaux, notamment pour les entreprises œuvrant dans les secteurs sensibles tels que la finance, la santé ou les ressources humaines. Par exemple, une IA biaisée peut influencer injustement les décisions de recrutement, pénaliser certains profils clients, ou favoriser des choix commerciaux contestables.

Pour faire face à ces enjeux, les entreprises doivent mettre en œuvre des audits réguliers des algorithmes, réaliser des tests de conformité éthique et renforcer la diversité des équipes de développement pour limiter les angles morts. La sensibilisation des décideurs à ces risques et l’intégration de mécanismes correctifs sont également essentielles.

Enfin, la réglementation IA à l’échelle européenne impose désormais des exigences strictes en matière d’évaluation des biais et de transparence, ce qui oblige les entreprises françaises à se conformer à ces standards sous peine de sanctions légales et d’impact négatif sur leur image.

Mesures pratiques pour réduire les biais algorithmiques

- Réaliser des audits indépendants sur les modèles utilisés

- Impliquer des experts multidisciplinaires dans le développement des algorithmes

- Utiliser des jeux de données représentatifs et diversifiés

- Mettre en place des mécanismes d’explicabilité des décisions algorithmiques

- Former les équipes aux risques éthiques liés aux IA

Transformation digitale et enjeux de protection des données dans les entreprises françaises

La transformation digitale, accélérée par l’usage intensif de l’intelligence artificielle, impose un renforcement des politiques de protection des données. Dans ce contexte, les entreprises françaises doivent respecter non seulement les normes européennes du RGPD, mais aussi anticiper les exigences spécifiques relatives à la confidentialité et à l’intégrité des données traitées par des systèmes d’IA.

La manipulation des données sensibles via des interfaces automatisées peut aggraver les risques de fuites et d’utilisation abusive. Par conséquent, une politique de cybersécurité renforcée doit conjuguer l’emploi d’outils techniques et une gouvernance rigoureuse, incluant la définition de rôles clairs et la responsabilisation des acteurs.

La sécurisation des données passe également par la maîtrise des flux avec l’extérieur. Les entreprises françaises sont encouragées à limiter les échanges avec des plateformes externes non certifiées ou situées hors Union Européenne, privilégiant des solutions souveraines qui garantissent un contrôle accru sur les données. Cette approche participe à préserver la confiance des clients et partenaires, facteur clé dans la consolidation des relations commerciales sur le long terme.

Approche stratégique pour une intégration réussie de l’IA dans les entreprises françaises

Enfin, pour maximiser les chances de succès de la transformation digitale et minimiser les risques, les entreprises françaises doivent adopter une approche stratégique globale et intégrée. Celle-ci mobilise non seulement les technologies d’intelligence artificielle, mais aussi la formation des équipes, la révision des processus métiers, ainsi que la mise en place d’un pilotage de la sécurité et de la conformité.

Une gouvernance adaptée de l’IA inclut la nomination de responsables dédiés, la mise en place de chartes d’éthique et la collaboration étroite avec les autorités réglementaires. Ce cadre doit aussi favoriser l’innovation tout en garantissant un usage responsable et transparent.

L’histoire de ces trois entreprises illustre que l’innovation ne va pas sans vigilance. Le développement des compétences internes, la sensibilisation aux risques et la transparence sur les pratiques autorisées assurent un équilibre entre exploitation des potentiels de l’IA et maîtrise des dangers inhérents.